A história repete-se. Em 1905 – sim, numa época em que os automóveis ainda davam os primeiros passos e a condução autónoma estaria provavelmente ao nível da bruxaria ou dos extraterrestres –, foi discutido entre os estudantes da Universidade do Wisconsin um problema moral que ainda hoje é alvo de estudos e de reflexão. Consistia em imaginar um eléctrico numa descida, desgovernado e sem travões, e um funcionário responsável pela agulha de uma bifurcação, que podia decidir se o veículo continuava em frente, atropelando uma multidão, ou se o deslocava para a linha da direita, atropelando apenas uma criança. Mais precisamente, o filho do operador da agulha.

E porquê este regresso ao passado? Porque esta discussão, conhecida como o “Dilema do Trolley”, ainda hoje continua actual. Sobretudo agora, com a introdução dos veículos autónomos, que têm de assumir o papel do operador da agulha e serem programados para decidir quem, em caso de ausência de outras soluções menos dramáticas, devem sacrificar.

Máquina versus homem

Felizmente, poucos são os condutores que têm de tomar, ao longo dos seus milhares de quilómetros ao volante, uma decisão tão importante e potencialmente tão traumática, como a de fazer de Deus e decidir entre duas vítimas, quando não há outra solução. O New York Times publicou um artigo que reflecte o problema, apoiado num trabalho do Instituto de Tecnologia de Massachusetts (MIT, na sigla em inglês).

Mais uma vez, é essencialmente o problema do trolley que está em causa, pois o que interessa é saber, quando estamos ao volante de um carro sem travões, quem decidimos sacrificar na passadeira de que nos aproximamos rapidamente: a senhora grávida que está bem à nossa frente, ou do velhote que se encontra um pouco mais à esquerda? E, já agora, adaptando esta questão à condução autónoma, quem é que preferíamos que o nosso automóvel sem condutor poupasse?

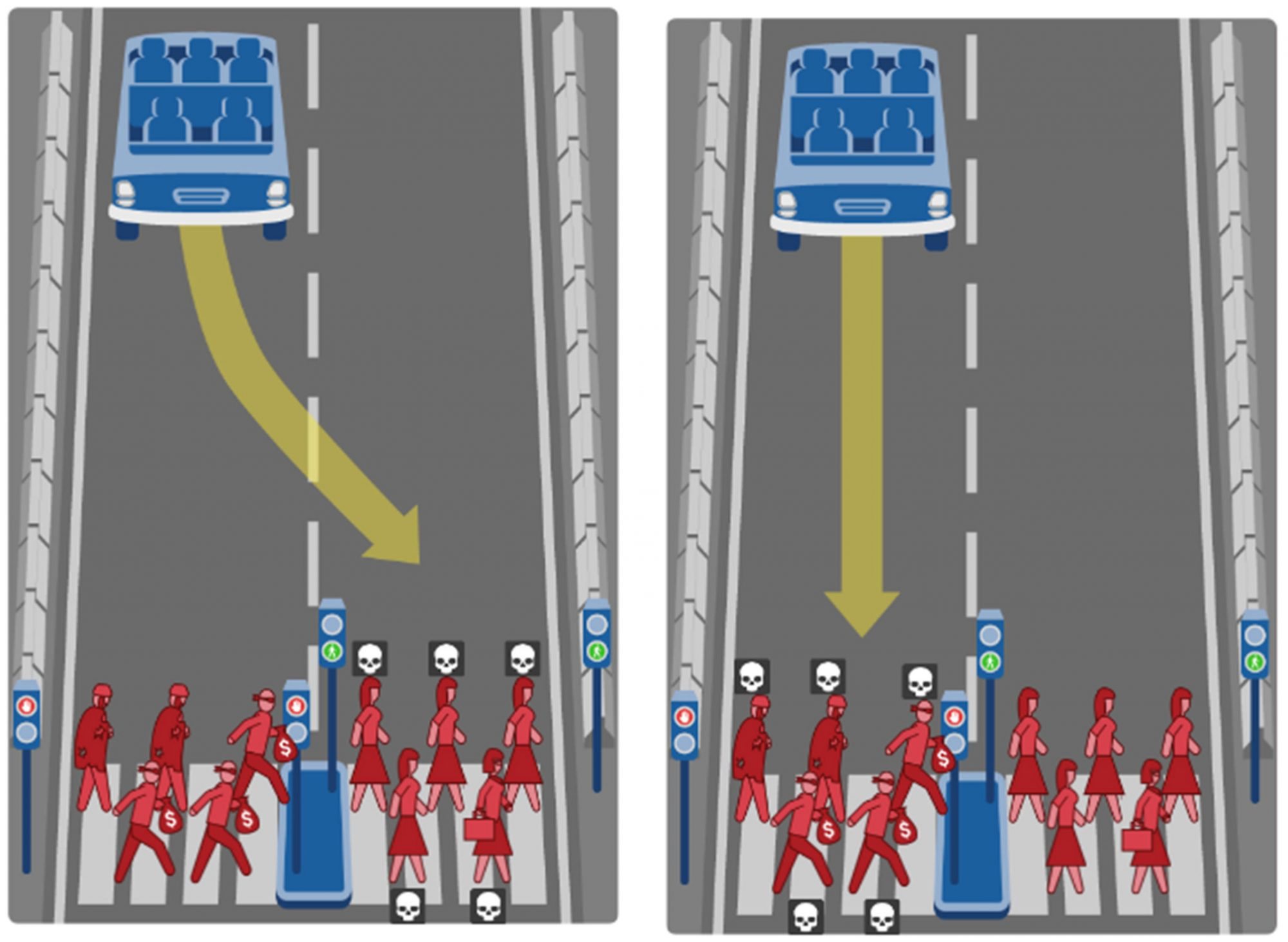

Um professor do MIT Media Lab, Iyad Rahwan, afirma que “as pessoas não gostam de ser colocadas perante estas questões”, e admite que “o tipo de respostas varia de país para país”. Mas hoje o MIT tem em seu poder milhões de respostas, oriundas de 160 países. Esses dados foram alvo de um estudo, ainda não publicado, que permite concluir que a maioria dos indivíduos se inclina em favor do mal menor, pelo que o algoritmo que controla a máquina que tomará as decisões sobre quem matar ou poupar, em caso de acidente, deverá respeitar este princípio.

Diga de sua justiça

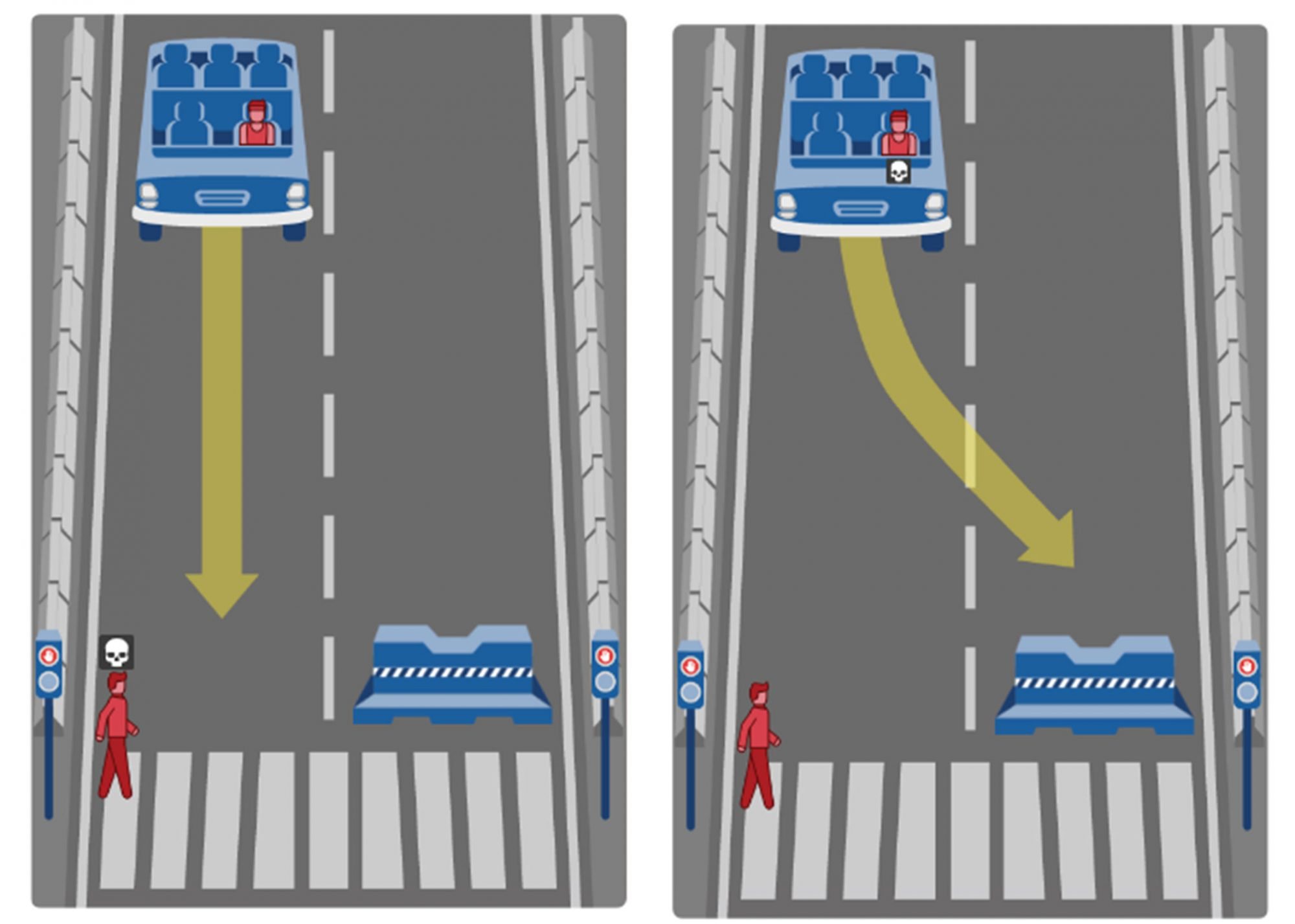

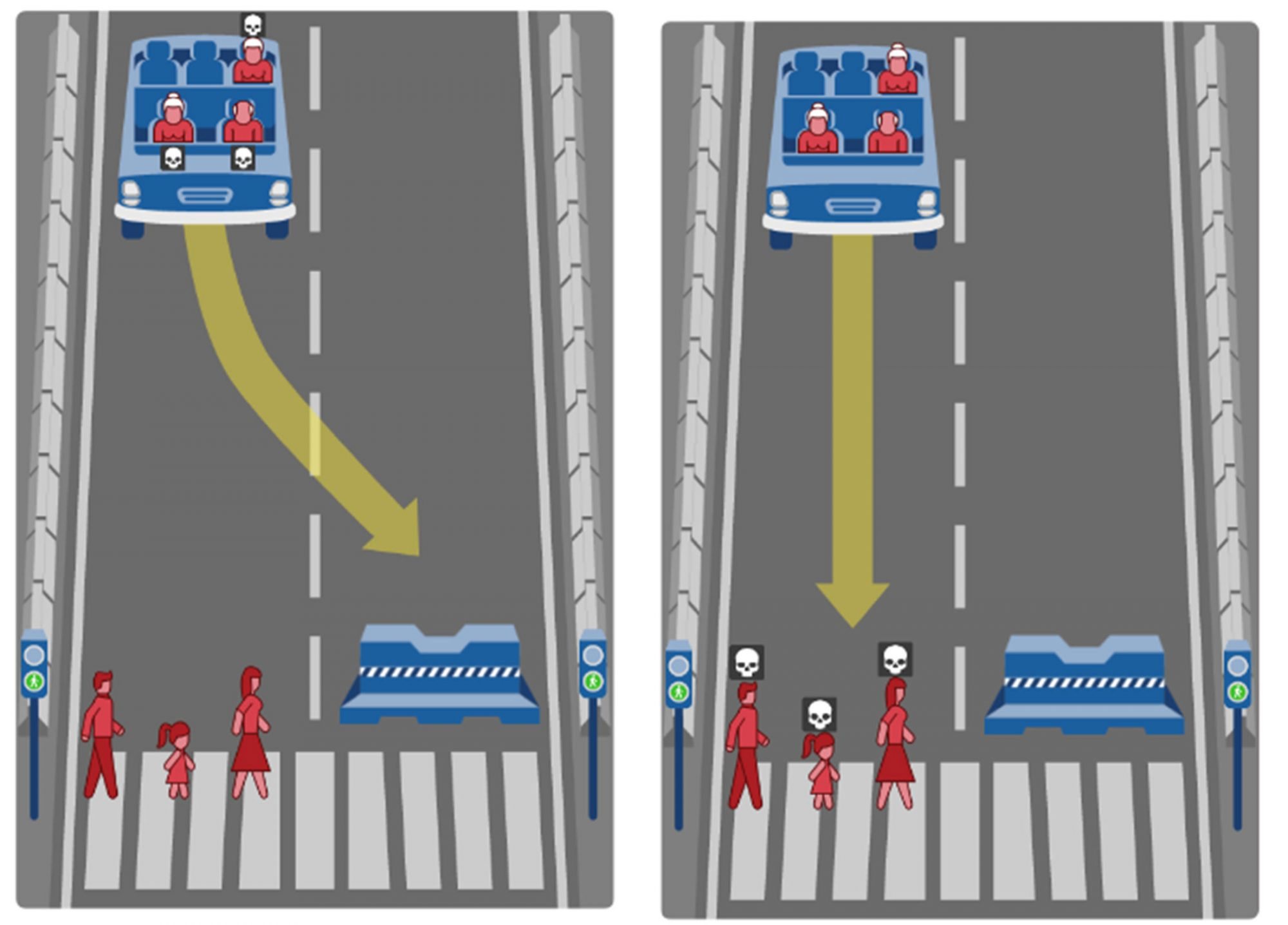

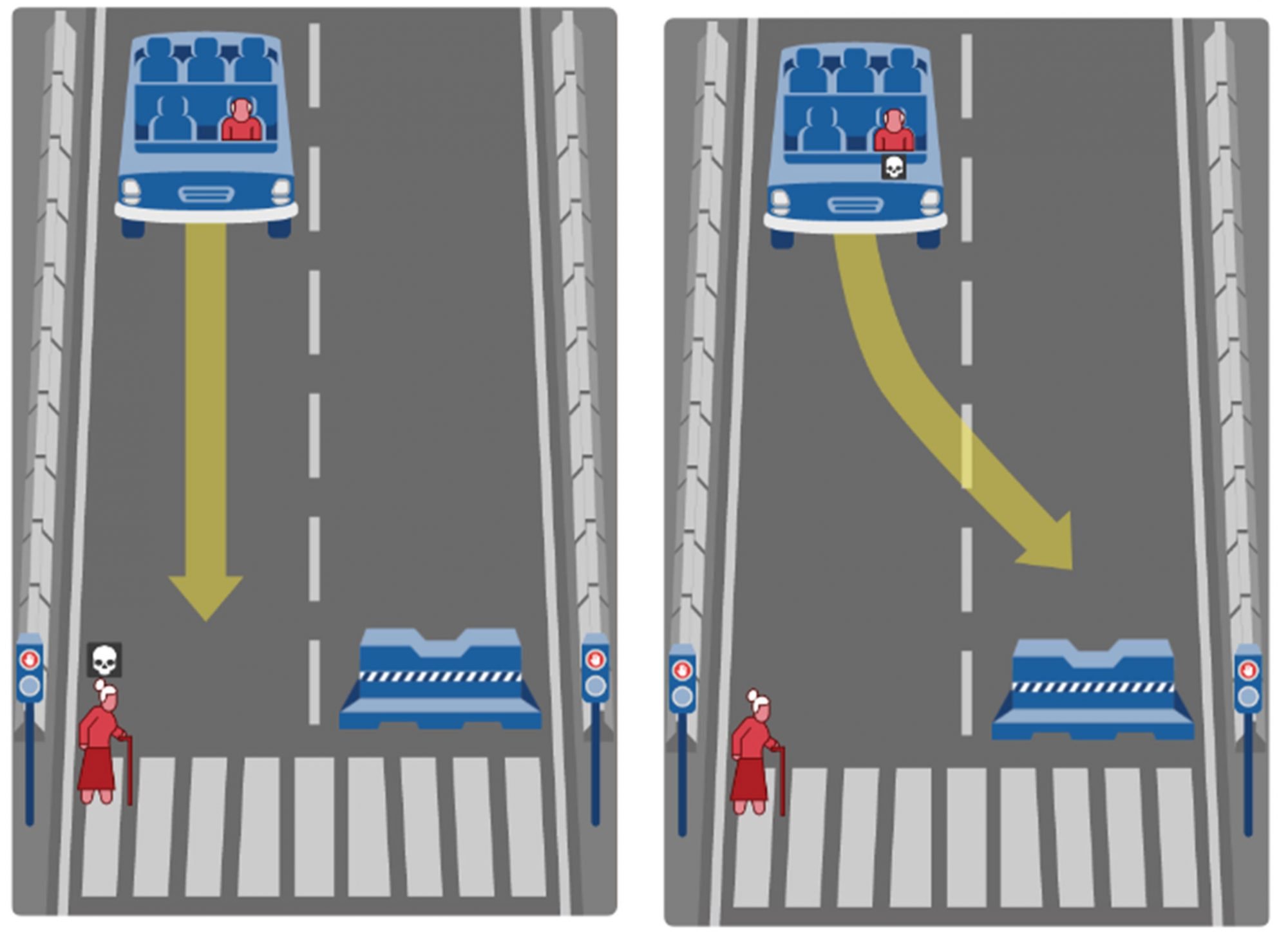

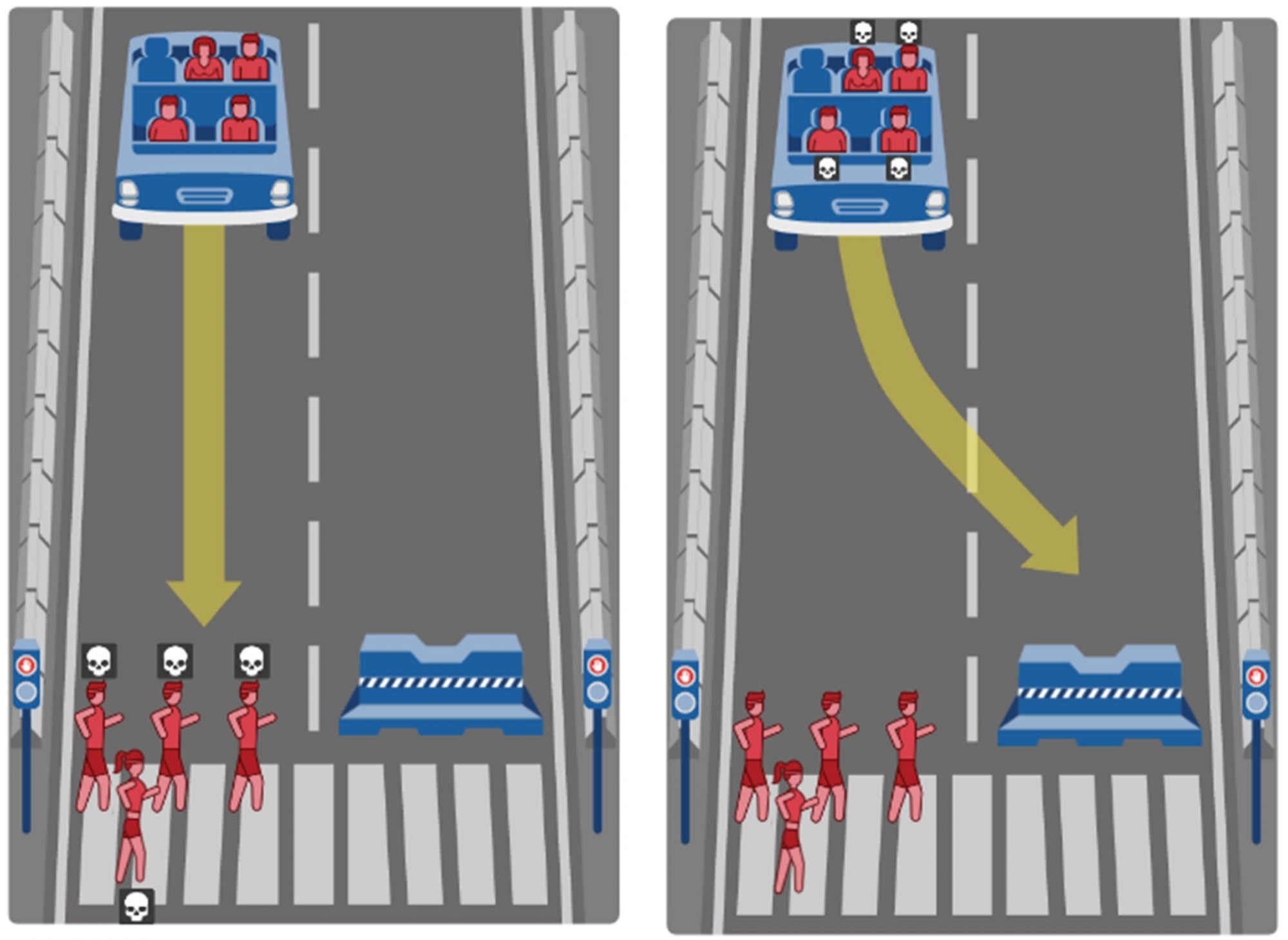

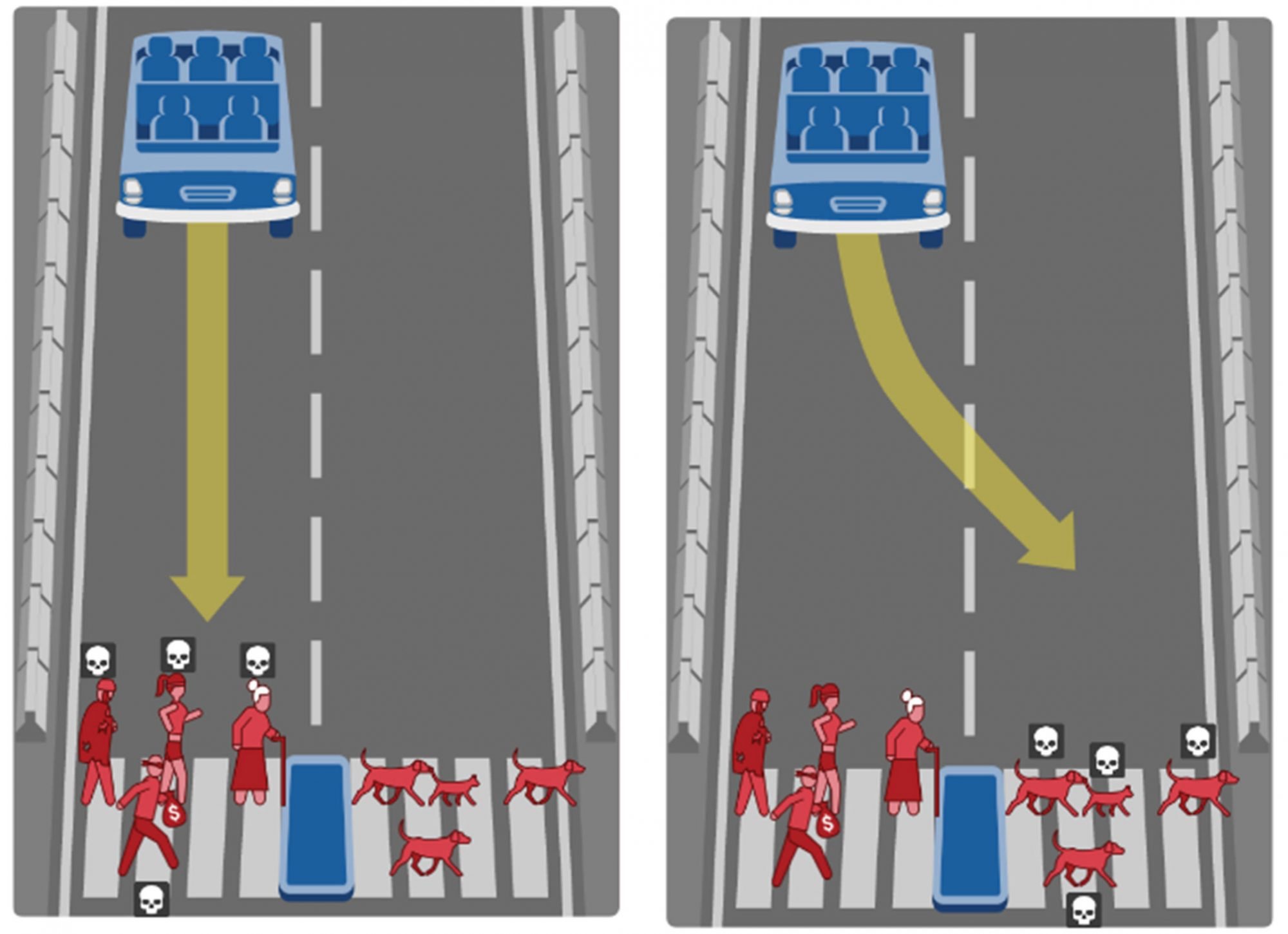

Não deixe que sejam apenas os outros a decidir e contribua, também você, para a programação do algoritmo que vai comandar “a moral” dos automóveis do futuro – sendo que, em matéria em condução autónoma, o futuro está aí mesmo ao virar da esquina, pois a Tesla já anunciou que a vai disponibilizar a 100% até ao final deste ano. Para isso, o MIT desenvolveu a Moral Machine, um site que lhe permite participar activamente na forma como o seu automóvel se deverá comportar perante um cenário de vida ou de morte. As questões não podiam ser mais simples, mas os problemas morais que levantam são complexos.

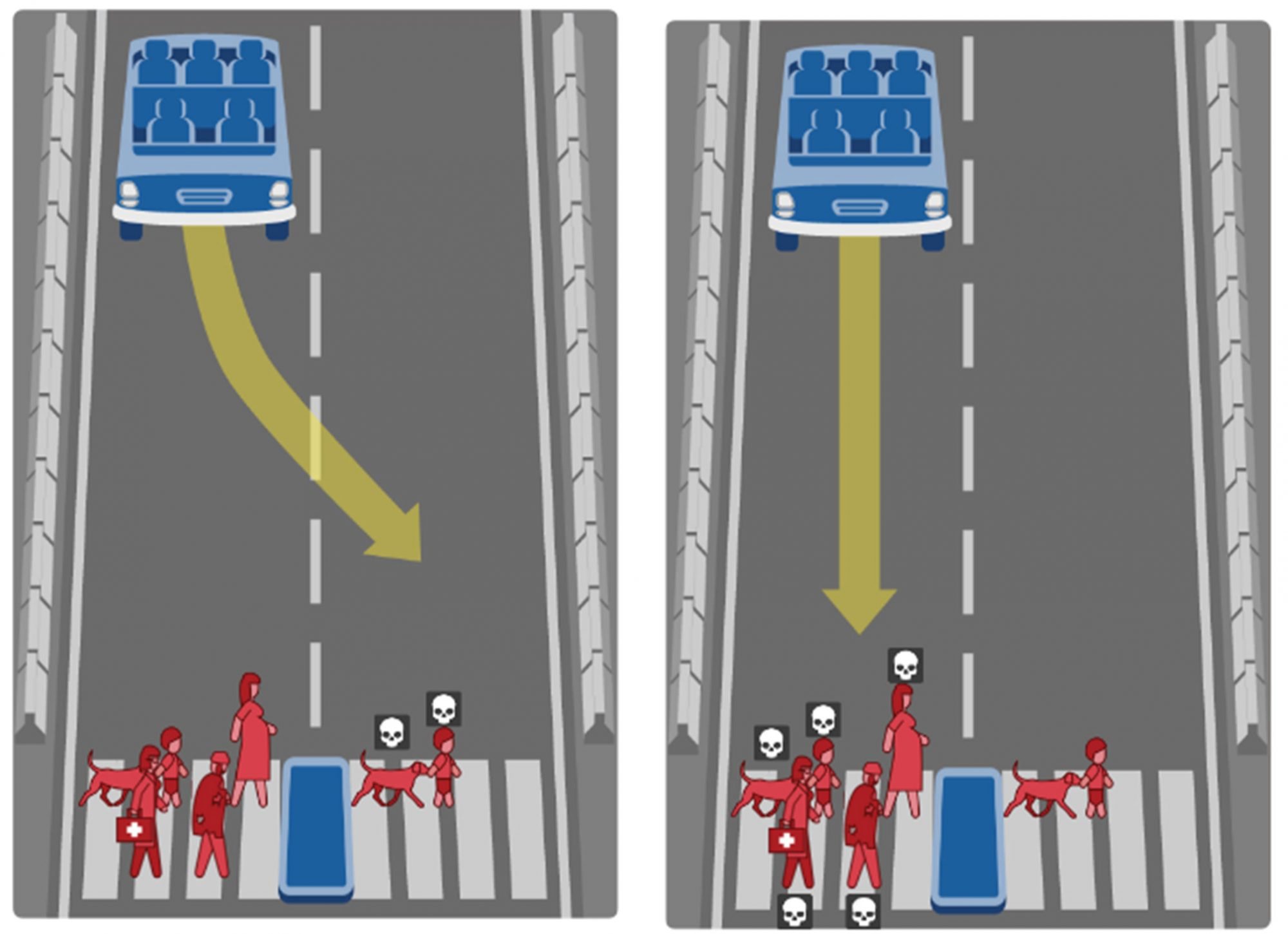

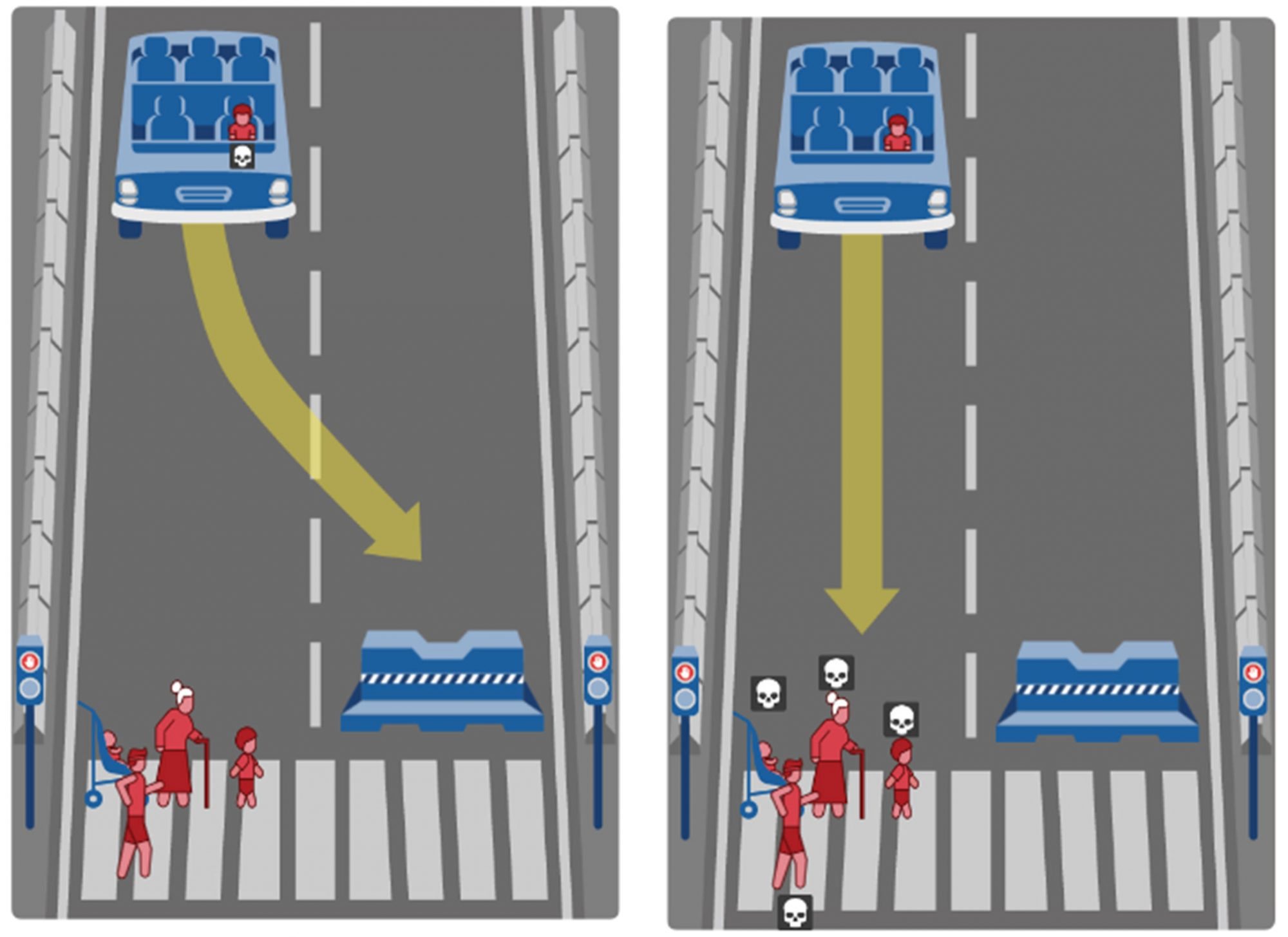

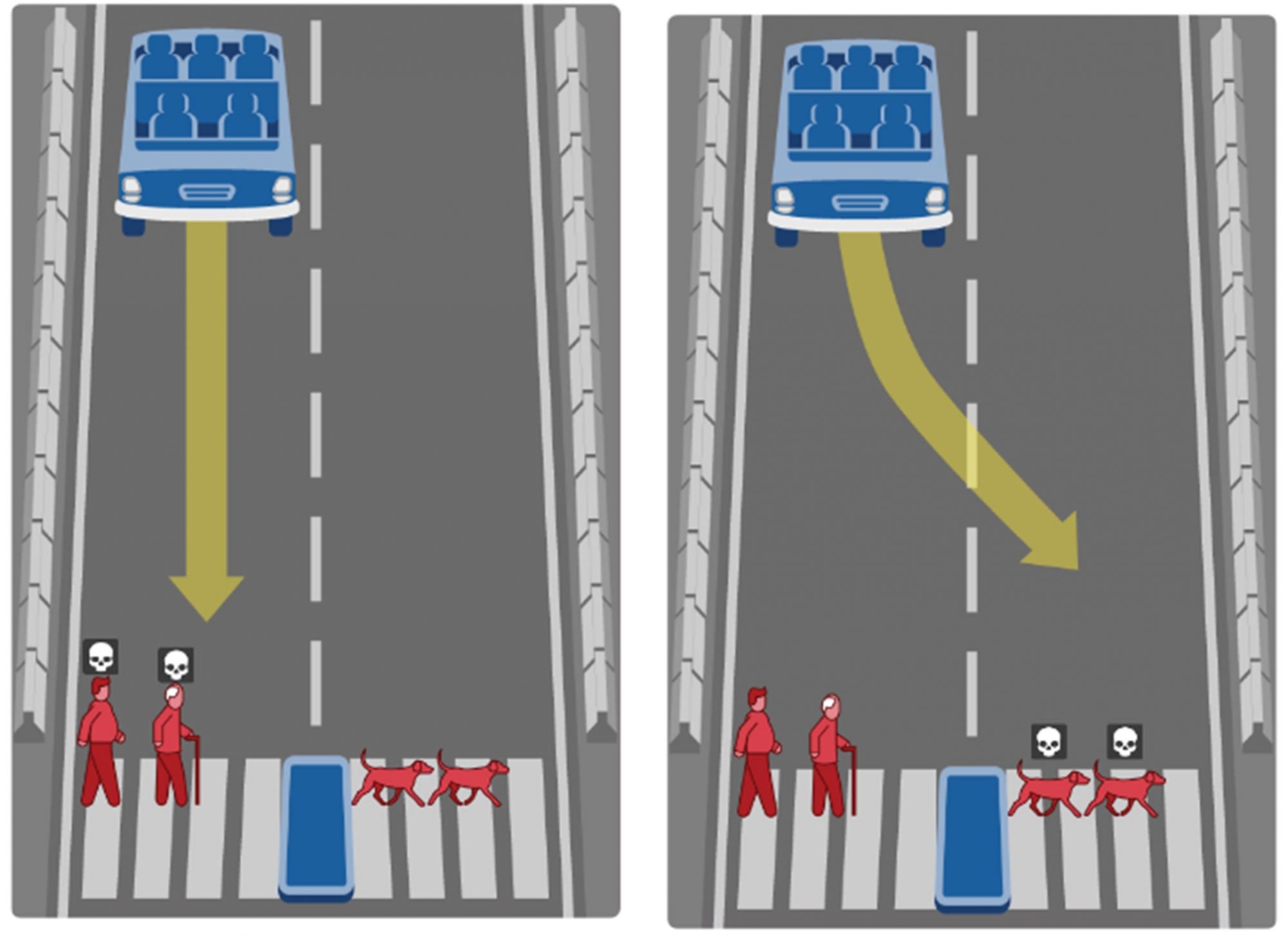

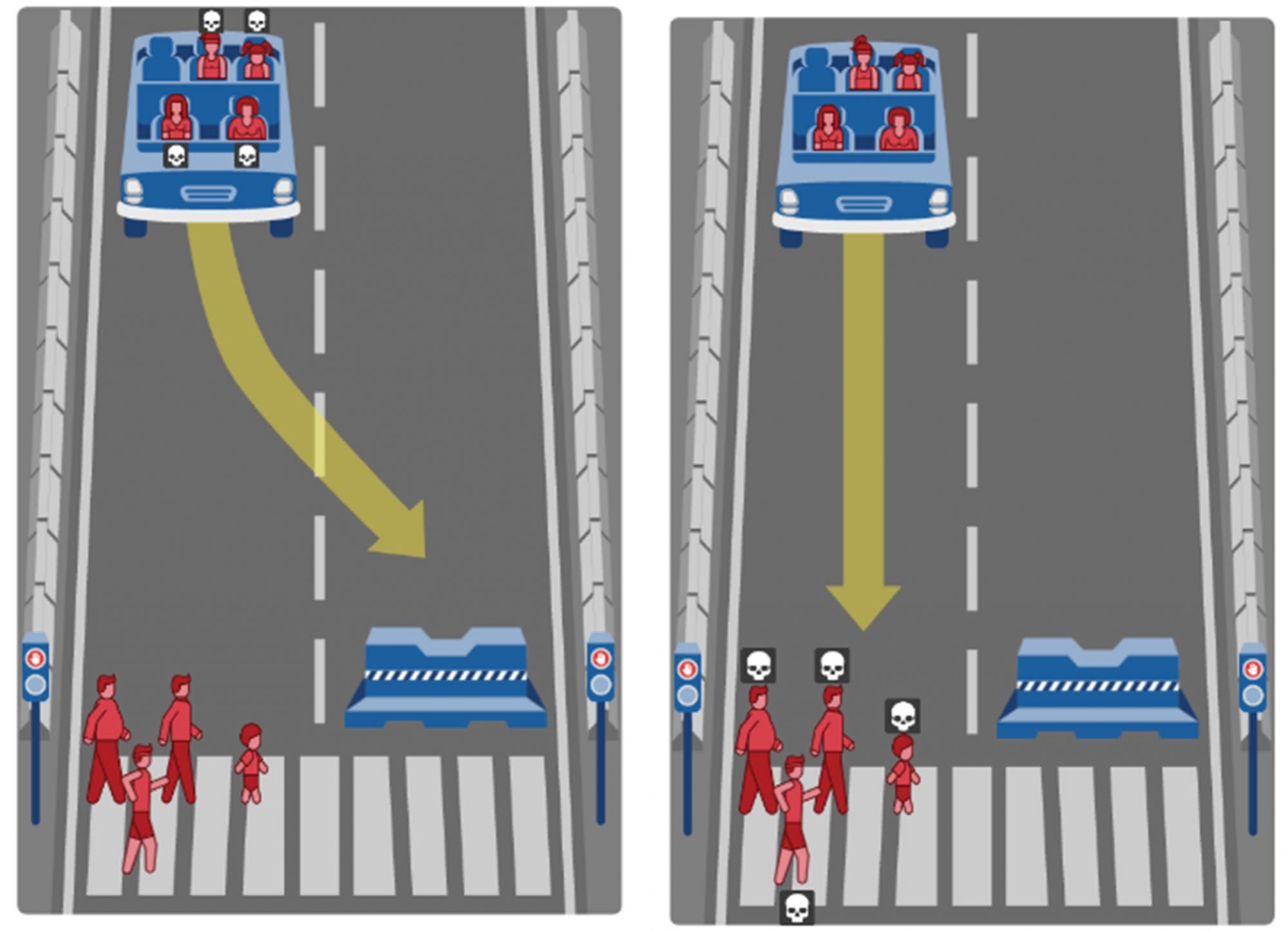

Entre na Moral Machine e seja o juiz de uma série de situações em que tem de decidir quem vive e quem morre. Eis como funciona: imagine-se a ver a situação à distância, fora do veículo que circula autonomamente, e que pode ter alguém a bordo ou não, consoante o caso. À sua frente, na passadeira, cujo sinal pode estar vermelho ou verde, há adultos, crianças, criminosos, grávidas e dois tipos de animais… O acidente é sempre inevitável e, como tal, há que fazer opções.

Pode ainda criar os seus próprios cenários e propô-los a outros, para que os julguem também, ou escolher vários tipos de vítimas – de crianças a criminosos, e até entre pessoas e animais, sendo que dentro desta última categoria, pode ainda comparar as reacções dos participantes perante cães e gatos e concluir de qual gostam mais. Ou menos.

Parece um jogo, mas na realidade é muito a sério. A sua vida, bem como a dos seus filhos, pode vir a depender das respostas a estas questões.

[jwplatform TRFyihf2]