Evoluir, melhorar, aumentar a exigência, levantar a fasquia, aspirar a mais e estar em constante movimento é a força motriz da evolução educacional e civilizacional. Mas, em Portugal, é depressivamente frequente ouvir e ler, de aparentes experts e connaisseurs, que o sistema educativo nacional está imobilizado, que os conhecimentos dos alunos não evoluem, ou que regridem mesmo, nas matérias em que são avaliados. Que é preciso rasgar, alterar, corrigir, melhorar as cartilhas, os curricula, a formação dos professores, a avaliação, …, porque… o sistema não evolui, está estagnado, perdeu o movimento!…. Aparentemente, o passatempo nacional de autoflagelo galgou da oralidade do fado para o renascido eduquês ou «eduquês recuperado». E com ele, se justificam mudanças cíclicas de currículos e de aprendizagens, fundamentais, mínimas, essenciais, e competências do Séc. XXI, que como o pensamento crítico, a criatividade, a resolução colaborativa de problemas nos chegaram, tão recentemente, da antiguidade clássica e do renascimento…

Contudo, para além de resultados pontuais de estudos, provas e exames que num ano sobem e no outro descem, não se entende como, aparentemente, os estudos internacionais, como o PISA, revelam uma evolução estatisticamente significativa, isto é, que não é fruto do acaso e da boa sorte, enquanto que os exames nacionais revelam um preocupante imobilismo. Pergunta-se «como encaixar que as várias avaliações internacionais (como o PISA ou o TIMSS) apontem para melhorias significativas e consolidadas nos desempenhos dos nossos alunos nos últimos 10 anos e que tal não se reflicta nos exames nacionais?». Contra-argumenta-se com «A incapacidade de resistir à tentação fácil de comparar resultados de provas nacionais com resultados de estudos internacionais. Este hábito, aliás praticado por inúmeros interlocutores, deve, de uma vez por todas, ser erradicado.»

Será? Existem dados objetivos que possam confirmar ou infirmar a hipótese da falta de validade das avaliações nacionais, ou a impossibilidade de conciliar os resultados das provas nacionais e internacionais? As avaliações nacionais e as internacionais estão condenadas ao «choque fontal»? Os dados existem ou o melhor que se consegue são «opiniões» de suporte empírico duvidoso, mas, que ainda assim, alimentam ideologias educativas e as consequentes mudanças cíclicas na educação? Mudanças que, de tão frequentes, levam a apelos aflitos, de quem educa no terreno, por «mais respeito pela educação», pela estabilização dos curricula e das avaliações?

O caso da matemática…

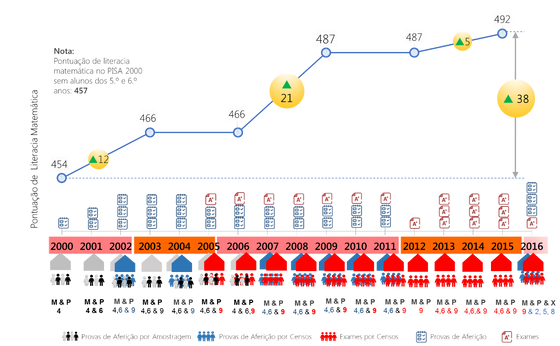

Por simplificação, porque o espaço é limitado, consideremos apenas o caso da matemática. A figura 1 ilustra a evolução dos resultados nacionais de literacia matemática, como avaliada pelo PISA, representada em paralelo com as avaliações externas no mesmo período temporal.

Figura 1 – Evolução dos resultados de literacia de matemática como avaliada pelo PISA (2000 – 2015) e avaliações externas no ensino básico no mesmo período. Nota: M – Matemática, P – Português, X – Várias disciplinas, 4 – 4.º ano, 6 – 6.º ano, 9 – 9.º ano, 2- 2.º ano, 5 – 5.º ano, 8 – 8.º ano. Fonte: Adaptado de OECD (2000-2015) e DGE (2000-2016)

No período dos 15 anos de avaliações PISA, as pontuações médias de literacia matemática aumentaram 38 pontos. A evolução da literacia de leitura e da literacia cientifica foi de 28 e 42 pontos, respetivamente. A correlação entre literacias, avaliadas pelo PISA, é superior a 0,85. O sistema evolui consistentemente em Matemática, Leitura e Ciências. O período em que se observa a maior evolução no PISA – entre 2006 e 2009 – ocorre após a implementação dos exames de 9.º ano e a «coincidência temporal é inegável». Esta evolução corresponde, na escala do PISA, a quase um ano de escolaridade e posiciona Portugal, pela primeira vez, acima da média da OCDE. A evolução do sistema educativo nacional, à luz do PISA, é evidente. Para Andreas Schleicher, o diretor de Educação e Competências da OCDE, «Portugal é a maior história de sucesso da Europa no PISA». Ainda assim, por cá, nem sempre se valoriza esta evolução que se diz ser «relativamente modesta» e inconsistente com os resultados das avaliações externas. Estas, por sua vez, diz-se, estão feridas por currículos extensos reduzidos ao «ensina-se apenas para os exames», desadequados às exigências das sociedades modernas, sendo reveladoras da «falência» do sistema educativo que continua com «problemas de fundo por resolver». Consequentemente, estarão as avaliações externas em choque frontal com as conclusões dos estudos internacionais de avaliação de alunos?

As provas finais de ciclo podem ser comparadas com as avaliações do PISA?

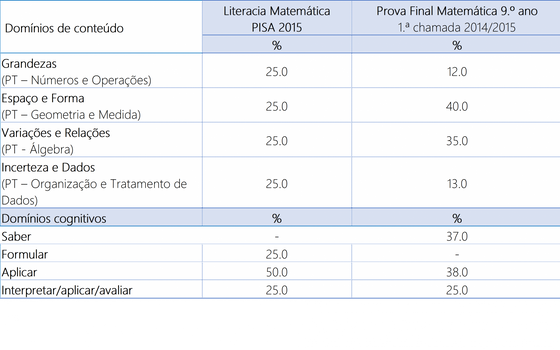

Os testes PISA e as provas finais do 1.º ciclo do ensino básico, nomeadamente as de matemática do 9.ºano (o ano de escolaridade mais próximo do teste PISA em que existe avaliação externa) têm objetivos diferentes. Os testes PISA não avaliam conteúdos curriculares, mas antes em que medida os alunos de 15 anos (em 2015, estes alunos frequentavam maioritariamente o 9.º e o 10.º ano, representando respetivamente 19,9% e 56,6% da amostra) são capazes de mobilizar os seus conhecimentos de matemática, de leitura e de ciências para resolver problemas do dia a dia. As provas finais, vulgarmente designadas por exames, do 9.º ano, enquanto avaliação sumativa externa, têm como objetivo principal certificar o final do 1.º ciclo do ensino básico. E, diz-se, avaliam prioritariamente a memorização de conhecimentos programáticos; pecam na capacidade de aplicação de conhecimentos na resolução de problemas, no pensamento crítico e estão desalinhadas com as competências do Sec. XXI. Os seus resultados, diz-se, não são, não podem ser, comparáveis com os resultados do PISA. Será? A figura 2 apresenta o peso percentual dos domínios de conteúdo e cognitivos do teste de literacia matemática no PISA 2015 e da 1.ª chamada da prova final de matemática do 9.º ano no ano letivo de 2014/2015.

No PISA, os 4 domínios de conteúdo têm pesos equivalentes; na prova final de matemática foi dada maior ênfase à «Geometria e Medida» e à «Álgebra». Efetivamente, a prova final de matemática apela à enumeração de conhecimentos (em 2014/2015, na 1.ª chamada, 37% dos itens incidiam sobre o domínio do «Saber»), o que não se observa, explicitamente, no teste PISA. Naturalmente, para «formular, aplicar e interpretar» é necessário «saber» sendo este processo aquele que evoca menores recursos cognitivos. Relativamente ao processo cognitivo mais complexo, «interpretar/aplicar/avaliar», este teve o mesmo peso percentual no PISA e no exame nacional.

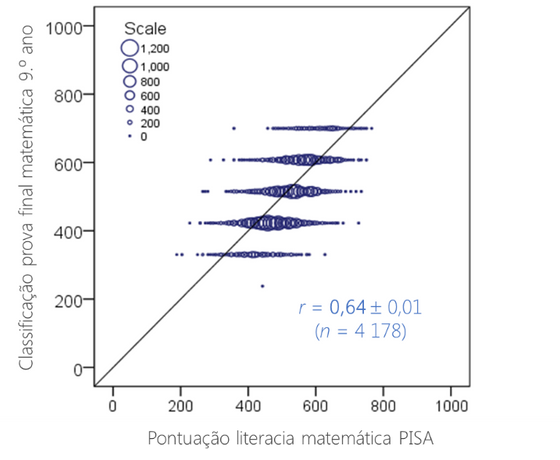

Naturalmente, porque as provas de final de ciclo e o PISA têm objetivos, diferentes, são defensáveis conteúdos e cognições avaliadas em proporções diferentes. Mas, avaliam, os testes PISA e as provas finais, diferentes construtos? É expectável que um aluno com bons resultados no exame do 9.º ano, tenha resultados inconsistentes no PISA ou vice-versa? Num estudo apresentado na European Conference on Educational Research de 2017, observou-se uma relação estatisticamente significativa entre os desempenhos de literacia matemática do PISA e as classificações finais da 1.ª chamada do exame de matemática do 9.º ano de 2014/2015 (figura 3). A correlação observada entre as duas avaliações, nos 4178 alunos para os quais foi possível emparelhar as classificações finais e os resultados PISA, foi de 0,64. Este valor é da mesma ordem de grandeza da correlação observada entre a classificação final interna, atribuída pelos professores no final do ano letivo, e a classificação final externa (0,69). A dimensão da correlação observada é fonte de evidência da validade concorrente das duas medidas.

Figura 3 – Correlação entre as classificações, convertidas para a escala do PISA (0-1000 pontos), do exame de matemática do 9.º ano e a pontuação de literacia matemática obtida pelos alunos do 9.º e 10.º que realizaram o PISA 2015. Fonte: DGEEC (dados não públicos) e OCDE (2016).

Os conhecimentos dos alunos estão estagnados?

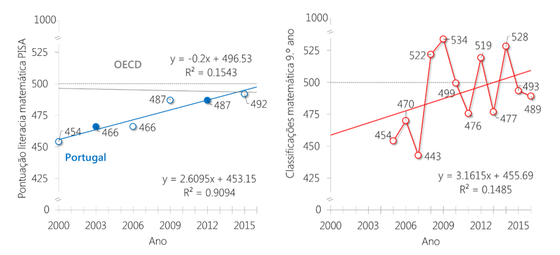

O discurso corrente, nem por isso tão recente, afirma que apesar da natureza pública das provas finais, esse conhecimento não tem sido absorvido pelos professores nas suas práticas letivas – ao mesmo tempo que, em ano de prova, se insinua que professores e escolas só ensinam a matéria do exame. As variações dos resultados de ano para ano, diz-se, não permitem apresentar outra conclusão do que a da imobilização do sistema. Os dados do PISA demonstram uma evolução. E os dados dos exames? A figura 4 coloca lado a lado a evolução da literacia matemática avaliada pelo PISA e as classificações da 1.ª fase do exame de matemática do 9.º ano, convertidas na escala do PISA (0-1000 pontos, com ponto central da série de 500 pontos).

Figura 4 – Pontuações da literacia de matemática avaliada pelo PISA e classificações da 1.ª chamada do exame de matemática do 9.º ano no período temporal do PISA (convertidas para a escala do PISA).

Duas características são evidentes: 1) as classificações dos exames têm maior variabilidade do que as do PISA e 2) a tendência não é uniforme: em alguns anos os resultados sobem, relativamente ao ano anterior, noutros descem….

A primeira observação explica-se pelo facto de nos testes não-públicos do PISA existirem itens de tendência: um mesmo conjunto de itens é aplicado em diferentes edições do teste de forma a ancorar os resultados de cada ano PISA relativamente a um ano de referência (2003, no caso da literacia matemática). If you want to measure change, don’t change the measure! Desta forma é possível assegurar a estabilidade temporal da medida e a fiabilidade das comparações. Pelo contrário, as provas nacionais são públicas. Apesar dos seus autores fazerem um meritório esforço pela consistência entre provas, todos os anos são produzidos novos itens que devem ser diferentes dos itens de anos anteriores, mas ainda assim avaliar, respeitando as orientações curriculares, os mesmos conhecimentos e competências. É difícil defender a estabilidade temporal da medida quando o instrumento de medida muda todos os anos!

A segunda observação é uma consequência simples das leis da probabilidade: se os alunos não sabem mais, a probabilidade de observar, aleatoriamente, uma das 3 evoluções é igual para todas: ora sobe, ora desce, ora se mantém. Mas qual é a tendência de médio/longo prazo? Recorrendo a uma técnica estatística simples, a regressão linear, que os alunos aprendem na matemática do 10.º ano, podemos estimar a evolução média das classificações do PISA e dos exames de matemática do 9.º ano. No PISA, a evolução foi de 2,6 pontos por ano, sendo 39 pontos a estimativa da evolução acumulada nos 15 anos de PISA. A mesma evolução nas provas de final de ciclo a matemática foi de 3,2 pontos por ano. No período de 15 anos, a evolução estimada é de ca. 47 pontos, o equivalente a meio desvio-padrão da escala do PISA, quase um ano de escolaridade! A evolução média registada no PISA é acompanhada pela evolução média dos resultados das provas de final de ciclo de matemática do 9.º ano. Se o PISA revela a evolução, estatisticamente significativa, da literacia matemática dos alunos Portugueses, as provas nacionais…

Reza a história que o filósofo, físico e matemático italiano Galileu Galilei sussurrou «…E pur si muove!» (… e, no entanto, ela move-se!) ao ouvido do presidente do Tribunal Romano do Santo Oficio, quando, em 1633, foi condenado a renegar a teoria heliocêntrica de que a Terra não era o centro, imóvel, do universo. Acusado de desobediência à visão dominante da Santa Igreja, seja verdade ou lenda, Galileu evitou seguir o caminho dramático do seu contemporâneo, Giordano Bruno, que ardeu na fogueira da Inquisição. Abdicando da razão das suas observações empíricas, Galileu terá, ainda que com voz contida, mantido, perante o tribunal, a coerência, dignidade e a credibilidade que a história dos homens lhe granjeou.

Professor associado de estatística e de métodos de investigação no ISPA-IU. Entre 2014 e 2017 foi vogal do C.D. do IAVE, I. P. onde coordenou os estudos internacionais de avaliação de alunos (PISA, TIMSS, TIMSS Advanced, PIRLS, ICILS).

‘Caderno de Apontamentos’ é uma coluna que discute temas relacionados com a Educação, através de um autor convidado.