“Search outside the box” foi o mote do evento da tecnológica norte-americana dedicado às ferramentas de pesquisa, o Google Search On. Na terceira edição do evento, ficou patente que a grande aposta da gigante de pesquisa continua a ser o reforço das capacidades de pesquisa visual.

Há muito que pesquisar no Google deixou de ser feito apenas com recurso a texto. Ao longo dos anos a empresa tem vindo a dedicar esforços à pesquisa por voz e, mais recentemente, através de imagem. Neste último campo o maior exemplo são as capacidades da Google Lens, apresentada em 2017, a opção de pesquisar através da câmara do smartphone.

Mas a empresa quer continuar a pensar em novas formas de pesquisar, refere Rajan Patel,vice-presidente de engenharia e pesquisa da Google, incluindo aquelas que sejam mais “naturais e intuitivas” e que “funcionem de uma forma mais parecida com a mente humana”.

A lista de novidades de pesquisa é extensa e divide-se entre ferramentas que vão chegar à pesquisa, ao Google Maps e ainda às ferramentas de compras da empresa, o Google Shopping. Uma boa parte das funcionalidades que aí vem só estará disponível, numa fase inicial, no mercado norte-americano.

Multisearch vai ter mais idiomas e tradutor no Google Lens foi afinado

A pesquisa Multisearch, anunciada em abril deste ano, é uma forma de conseguir aliar mais do que uma forma de pesquisar, juntando a imagem ao texto, por exemplo. O exemplo mais fácil é o de pensar numa peça de roupa. Tem uma imagem de um camisola mas queria mesmo que fosse de outra cor? Através desta ferramenta Multisearch pode apresentar ao Google a imagem da camisola e escrever por exemplo verde. As imagens apresentadas vão ser de modelos semelhantes à peça de roupa que colocou na pesquisa, mas na cor pretendida.

Isto funciona não só para roupa, embora seja assumido pela Google que funciona melhor para compras, e a pesquisa também pode ser feita através de voz, se não quiser estar a escrever. Na altura do lançamento, a Google explicou que esta ferramenta só estava ao alcance dos utilizadores no mercado dos Estados Unidos. Em breve o cenário vai ser outro, já que nos próximos meses vai ser possível pesquisar em 70 idiomas.

Com o MUM, Google quer que se façam mais pesquisas com imagens

Os planos para a funcionalidade Multisearch não ficam por aqui, já que há ainda a ambição de pesquisar deste modo nas proximidades – uma ferramenta chamada Multisearch near me. A Google já tinha levantado a ponta do véu sobre este tipo de pesquisa, que chegará a partir do outono ao mercado norte-americano. Aqui a ideia é que possa usar na mesma uma imagem, que pode ser uma captura do ecrã ou qualquer outra guardada no telefone, e procurar, por exemplo, por um prato favorito ou uma peça de roupa nas lojas que estão na proximidade, ativando a localização.

O Google Lens não permite só fazer pesquisa – também consegue ser uma boa ferramenta quando precisa de traduzir algum texto que esteja numa imagem ou noutro suporte. A novidade neste campo está ligada à forma como o texto traduzido passará a ser apresentado no seu smartphone. Até aqui, esta tradução era feita apresentando umas barras que cobriam o texto original – em alguns casos, algo que pode resultar em perda de informação. A Google explica que otimizou os modelos de aprendizagem automática para conseguir evitar essas barras e apresentar o texto traduzido já na própria imagem.

A tecnológica promete que esta tradução pode ser feita em “100 milissegundos – menos do que um piscar de olhos”. Mas como é que isto vai funcionar? Através de modelos GAN (generative adversarial networks). A tecnológica norte-americana explica que esta ferramenta deverá ser lançada ainda este ano, mas sem especificar datas ou mercados concretos.

Mais atalhos para pesquisar e formas mais simples de perguntar ao Google

Ainda na área de pesquisa, que apesar da passagem dos anos e da multiplicação de negócios continua a ser um dos pilares da Google, haverá algumas alterações no campo dos atalhos. De acordo com o anúncio da empresa, estas mudanças vão estar especialmente ligadas à aplicação Google para o sistema operativo iOS. Será possível ver aqui atalhos para comprar a partir das capturas de ecrã – usando o Multisearch. Note-se que esta funcionalidade de atalhos só estará disponível em inglês e no mercado dos Estados Unidos.

Quem usa o Google já sabe que muitas vezes nem é preciso escrever a pergunta toda – os termos de pesquisa são muitas vezes completados. Em breve, vai ser possível pesquisar com recurso a tópicos para que possa orientar melhor a pesquisa. Por exemplo, se está a planear umas férias no México. Em vez de estar a procurar entre vários resultados, a ideia é que o Google possa ajudar a fazer os termos de pesquisa – como procurar por férias a dois ou férias em família, para que tenha os resultados mais relevantes com menor esforço.

Mais uma vez, esta é uma funcionalidade que não tem data de chegada a Portugal. Neste momento, a Google só se compromete com um lançamento em inglês e no mercados dos Estados Unidos, “nos próximos meses”.

Outra das mudanças vai ser notória nos resultados de pesquisa, que vão ficar mais visuais. Haverá uma reorganização dos resultados de pesquisa, para que consiga ver a informação mais relevante quando está a pesquisar. Por exemplo, para pesquisas de cidades, poderá ser apresentado no telefone algumas histórias visuais (quase como no Instagram) ou pequenos vídeos disponíveis. Também só vai estar disponível em inglês e nos Estados Unidos, de acordo com o anúncio desta quarta-feira.

A “vibe” dos bairros ou monumentos fotorealistas no Maps

É certo e sabido que a aplicação Google Maps já ultrapassou há algum tempo as duas dimensões. Depois das direções com indicações em realidade aumentada, por exemplo, há mais componentes a caminho do Maps – embora uma boa parte destes esforços estejam mais virados para os Estados Unidos.

Não é esse o caso da chamada Neighborhood Vibes – algo que poderia ser traduzido por vibração ou aura do bairro. A ideia aqui não passa por dizer se um bairro é bom ou mau, explica a Google, mas sim quais as áreas e recomendações que estão a ser mais partilhadas. Como é que isto vai funcionar? Através de uma combinação entre as recomendações dos utilizadores no Google Maps – esta comunidade faz mais de 20 milhões de contributos por dia – e as críticas, fotografias e vídeos.

Os pontos mais populares vão ter maior destaque nos Maps – com imagens em destaque. Estes resultados mais visuais vão chegar tanto à versão Android como iOS, nos próximos meses.

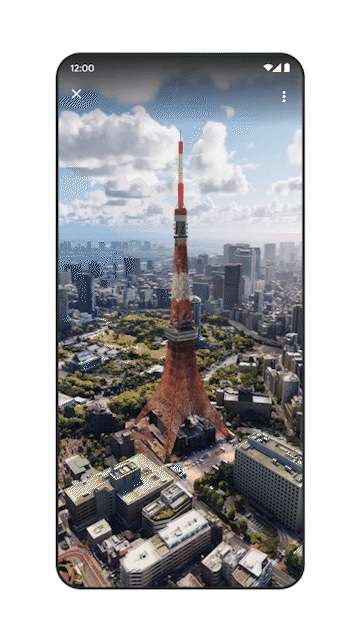

Algo que vai já ficar disponível são as visões fotorrealistas de alguns dos monumentos mais conhecidos. Diretamente a partir do Google Map vai ser possível encontrar até 250 imagens aéreas fotorrealistas de pontos conhecidos como a Acrópole, em Atenas, até à Torre de Tóquio. A Google aponta que este lançamento é “um avanço para a transformação [do Maps] num mapa mais imersivo”.

Por falar em vistas mais imersivas: em alguns pontos do mundo vai ser possível ver um mapa diferente, em que a combinação de imagens aéreas com indicações de trânsito ou estado do tempo vai dar outra capacidade de planeamento. Por enquanto, só Los Angeles, Nova Iorque, São Francisco, Londres e Tóquio é que vão ter esta vista imersiva, a partir dos próximos meses.

Já em Londres, Paris, Nova Iorque, São Francisco e Tóquio será possível usar a funcionalidade de pesquisa com a live view. Como é que isto funciona? Se estiver na rua com este tipo de visualização pode apontar para algum lado e ver logo qual é a classificação de um restaurante que está do outro lado da rua. Em vez de abrir o Google, pesquisar pelo nome do restaurante e encontrar a pontuação, basta apontar. Isto funcionará também para encontrar outros pontos de interesse, como caixas multibanco ou lojas.

Ainda na componente de mapas, há uma novidade a pensar nos programadores. Recentemente a Google lançou em Portugal uma funcionalidade que lhe apresenta o caminho mais ecológico possível – e a indicação de quanto combustível é que pode estar a poupar, desde que indique o tipo de motor do carro. Esta funcionalidade vai ser alargada até aos programadores de outras aplicações, para que esta informação também possa ser usada por empresas que dependem de mapas (serviços de mobilidade, entregas, etc).

Também há novidades nas compras, incluindo modelos 3D de calçado na pesquisa

Muitos utilizadores já recorrem à pesquisa online para explorarem opções e sobretudo preços quando estão interessados em comprar alguma coisa. As compras online subiram exponencialmente ao longo dos últimos dois anos, muito amparadas pela pandemia de Covid-19, mas a pesquisa online é cada vez mais usada como um apoio à compra.

Por isso, não é de estranhar que a Google aumente as ferramentas de pesquisa ligadas especificamente às compras. Uma das novidades deste ano é o aumento dos auxílios visuais na pesquisa de compras – a começar pelo calçado. Por enquanto só estará disponível nos Estados Unidos mas, se estiver a procurar sapatos, poderá logo ver um modelo 3D de uns ténis diretamente a partir da pesquisa. É certo que alguns retalhistas já disponibilizavam modelos 3D dos sapatos, mas era preciso estar dentro de um site. A funcionalidade chegará nos próximos meses aos Estados Unidos – não há previsão de quando poderá estar disponível em Portugal.

Mas há mais planos para os modelos de calçado 3D. A Google explica que as pessoas interagem quase 50% mais com modelos deste género do que imagens estáticas. No entanto, o facto de estes modelos serem mais dispendiosos e consumirem mais tempo aos comerciantes, poderá justificar o facto de serem menos usados. A partir do próximo ano, a começar pelos Estados Unidos, a empresa promete conseguir criar ativos 3D a partir de algumas fotos – tudo fruto dos avanços na área da aprendizagem automática.

Outro ponto de apoio à compra são as análises a produtos. A partir desta quarta-feira nos Estados Unidos já estará disponível um “guia de compras”, em que são compiladas análises de várias fontes credíveis, tudo num único ponto.

Por fim, a quantidade de informação sobre tendências e pesquisas que a Google tem – afinal, é o maior motor de pesquisa do mundo – faz com que consiga apresentar filtros de pesquisa mais dinâmicos. A tecnológica explica que estes filtros vão ser baseados em tendências de pesquisa em tempo real.

Com um exemplo concreto fica mais fácil: calças de ganga. Se quiser comprar umas calças online basta pesquisar no Google, mas a questão complica-se quando quer adicionar um filtro por tipo de modelo das calças. Até aqui, era possível filtrar cores ou tamanhos – mas nem tanto modelos diretamente no Google. Os filtros dinâmicos vão perceber de que é que as pessoas estão à procura, seja umas calças de boot cut ou retas. Consoante as pesquisas dos utilizadores, os filtros vão adaptar-se. Esta ferramenta vai estar disponível em alguns mercados europeus, mas Portugal fica, por agora, de fora da lista de mercados desta funcionalidade.