Não houve problemas técnicos e a explicação está por apurar. Em Portugal, os alunos de 10 anos pioraram a leitura, segundo o estudo internacional PIRLS, que faz essa avaliação de 5 em 5 anos. Assim, e apesar da descida de 528 pontos para 520 — os valores oficiais do Progress in International Reading Literacy Study —, na apresentação destes números, o Ministério da Educação optou por dividir os resultados entre quem fez a prova em papel (bridge) e quem a fez em formato digital. As dúvidas são, desde o início, muitas — começaram logo na apresentação dos dados aos jornalistas — e só após duas insistências do Observador a tutela clarificou alguns pontos. “A diferença de resultados entre a prova em papel e a prova em digital suscita questões importantes e que merecem a mais cuidada reflexão”, assume o Ministério da Educação.

Com base no olhar inicial do Governo, surgem duas realidades distintas: os alunos que fizeram a amostra em papel melhoraram o seu desempenho, enquanto que os que usaram computador pioraram. Isso mesmo se lê no relatório nacional do IAVE entregue aos jornalistas a 15 de maio, com embargo para as 9h de 16 de maio.

- “Os alunos que realizaram o teste em papel (PIRLS bridge) alcançaram um resultado médio de 531 pontos, mais 11 pontos em relação aos alunos que realizaram o digital PIRLS, e mais 3 pontos significativos, comparativamente com o resultado alcançado em 2016;

- Os alunos portugueses que realizaram o digital PIRLS 2021 obtiveram uma pontuação média de 520 pontos a literacia de leitura, o que representa uma diminuição de 8 pontos significativos, em relação a 2016.”

Com base nesta análise do IAVE, o Observador questionou o Ministério da Educação sobre o motivo desta diferença entre papel e digital, na apresentação aos jornalistas e, mais tarde, por escrito, já que os vídeos divulgados pela instituição responsável (IEA) pelo PIRLS, no final do embargo, contrariavam o que foi dito na conferência de imprensa.

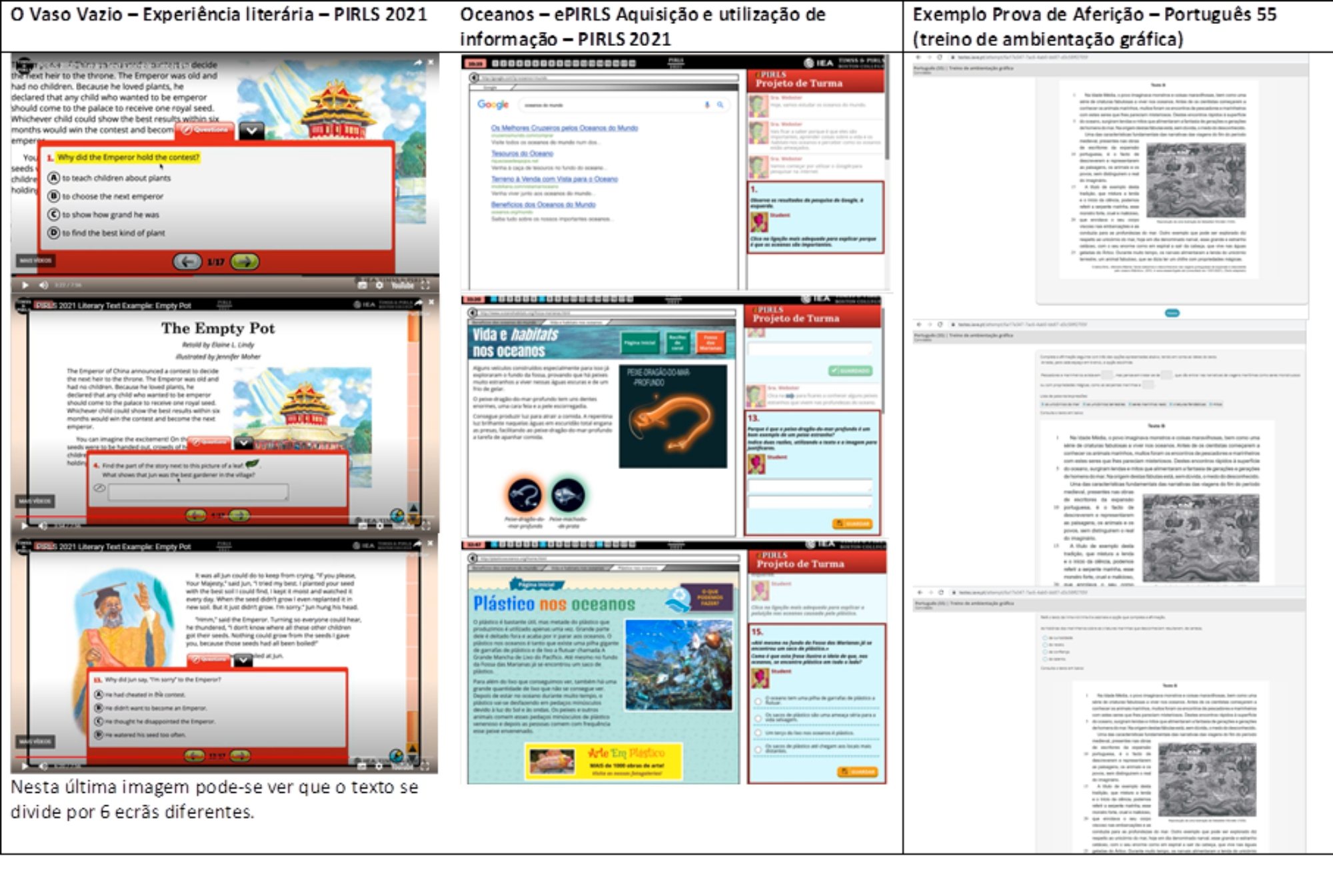

A primeira explicação (pública), do presidente do IAVE e do ministro João Costa, prendia-se com o facto de no PIRLS haver “uma mera transposição do papel para o digital, o que implica que os alunos, quando lhes são apresentadas as perguntas, não consigam voltar ao texto”. Os vídeos divulgados mostram que não é assim.

O vídeo pode ser visto aqui. Consulte a partir dos 3 minutos e 56 segundos

O Observador insistiu junto do Ministério da Educação, depois de divulgados os vídeos da IEA, se mantém a explicação de que “os alunos não conseguiam navegar nos textos, ou tirar as perguntas da frente”. Também questionou o gabinete de João Costa sobre qual a explicação para tal acontecer, se era um problema apenas de Portugal, e se aconteceu de forma generalizada no país. Por último, o Observador perguntou se teria havido problemas técnicos com o equipamento entregue aos alunos que justificassem problemas ao navegar nos textos.

Apesar da insistência do Observador, algumas questões ficaram sem resposta. Por exemplo, nunca foi diretamente respondida à questão sobre se o ministério mantém que “os alunos não conseguiam navegar nos textos, ou tirar as perguntas da frente” — embora as respostas a uma primeira insistência apontem no sentido de que a tutela mantém essa versão. Ao primeiro bloco de perguntas enviadas, a resposta foi a seguinte: “Confirma-se que no PIRLS em modo digital, e excetuando-se os textos ePIRLS, o texto e as perguntas não surgem simultaneamente, ao contrário do que acontece nas provas portuguesas de aferição digitais.”

No entanto, uma garantia foi dada em relação à outra questão. Não houve problemas técnicos que tornassem as provas digitais mais difíceis ou complexas para os alunos. “Importa referir que o teste foi realizado com recurso ao modo offline a partir de USB em equipamentos das escolas ou do IAVE quando necessário, quer uns, quer outros, satisfazendo os requisitos técnicos definidos pela IEA para a realização do teste e devidamente testados conforme estabelecido pela mesma entidade na lista de tarefas prévias à realização do teste.”

Não havendo, portanto, “nenhuma desadequação ou problema técnico que impossibilitasse a aplicação do teste e a realização do mesmo por parte dos alunos”, conclui-se na resposta.

Sobre a prova em si, e uma vez que os argumentos utilizados podem pôr em causa as capacidades técnicas do IEA, o gabinete de João Costa frisa que “o Ministério da Educação e o IAVE nunca afirmaram que a prova estava mal construída, limitaram-se a apresentar os resultados e as características do teste de forma a assinalar um dos fatores possíveis para as diferenças registadas entre modos de aplicação diferentes”. Mais uma vez sem referir como justificam que tenha sido dito aos jornalistas que não era possível aos alunos regressar aos textos, depois de se avançar para as perguntas — o que é mais do que uma mera apresentação dos “resultados e as características do teste”, sobretudo, porque tal informação não corresponde à verdade.

A resposta final: “Formato digital foi mais difícil”

O que se passou, então, com quem fez a prova digital? “A análise dos resultados do estudo bridge [papel] mostra diferenças em desfavor do digital para 7 de um total de 18 países”, sendo essa diferença “significativa” para Portugal, responde o Ministério da Educação. “Assim sendo, pode dizer-se que a realização destes itens trend em formato digital foi mais difícil para os alunos portugueses do que a sua realização em formato papel.”

O problema, responde o gabinete de João Costa, aconteceu com outros alunos envolvidos no estudo internacional. “Esta situação não acontece apenas para Portugal e como não foram realizados estudos qualitativos que permitam perceber a que se deveu esta diferença não podemos avançar com eventuais causas.” Ou seja, apesar das suspeitas, o motivo fica por explicar, embora questões técnicas — como, por exemplo, aparelhos digitais que não estivessem conforme os requisitos da IEA — sejam afastados.

“O que o IAVE confirmou foi que não existiram problemas técnicos no decorrer da aplicação do estudo que possam estar na origem desta realidade”, lê-se na resposta ao Observador. “Mais se regista que as imagens previamente enviadas [ao nosso jornal] retratam bem as características que a apresentação de umas e de outras provas apresentam, nomeadamente na facilidade ou dificuldade na (re)consulta do texto perante o item a ser respondido, a par da extensão dos textos, a ocuparem, ou não, mais do que um ecrã de visualização, com o impacto que destes factos decorrerá na navegação, para o leitor.”

▲ As imagens enviadas ao Observador

Questionado sobre o motivo que levou a que se sentisse maior diferença em Portugal do que noutros países, e como ela é interpretada pelo titular da pasta, o Ministério da Educação responde: “Não temos dados quantitativos nem qualitativos que nos permitam chegar a conclusões sobre o impacto que esta maior dificuldade no digital PIRLS assumiu em alguns países. O facto é que esta dificuldade se denota em vários países, de geografias diferentes, sendo que esta diferença é estatisticamente significativa em três deles (Portugal, China Taipé e Israel).”

Os fatores implicados nestas questões “são múltiplos e complexos”, acrescenta o ministério, “pelo que atribuir relações causais a fatores isolados sem dados inequívocos que suportem as afirmações não nos parece adequado”.

Qual foi a primeira explicação para a diferença?

Na conferência de imprensa em que o Governo apresentou a sua leitura dos resultados do PIRLS aos jornalistas — destacando positivamente a média de 531 pontos obtidos nas provas em papel —, foi apontado um motivo para a diferença de 11 pontos em relação à média do digital (520): a forma como os testes foram transpostos para digital.

Segundo explicou aos jornalistas Luis Santos — que coordena o Instituto de Avaliação Educativa, responsável por criar as provas e os exames nacionais —, no formato digital os alunos não conseguiam regressar ao texto principal durante o decorrer da prova para, por exemplo, tirarem dúvidas.

O ministro João Costa seguiu este raciocínio e garantiu que nas provas de aferição nacionais não haverá este problema. “Fazendo a comparação entre o PIRLS e as provas de aferição, no PIRLS há uma mera transposição do papel para o digital, o que implica que os alunos, quando lhes são apresentadas as perguntas, não consigam voltar ao texto. Nas provas de aferição nacionais o texto é sempre consultável e apresentado lado a lado com as perguntas.”

No PIRLS, segundo a leitura do Ministério da Educação, quem fez a prova em papel melhorou em relação a 2016 (3 pontos, estatisticamente irrelevantes); quem fez em digital, piorou (queda significativa de 8 pontos). O PIRLS considera como valor oficial os 520 pontos que, para serem comparáveis com os diversos países que participam do estudo e com anos anteriores, levam em conta diversas variáveis, incluindo os resultados em papel (bridge).

Depois de dois anos letivos em pandemia, seria até expectável que os alunos estivessem mais familiarizados com os meios tecnológicos, o que não aconteceu, frisou, na conferência de imprensa, o ministro da Educação. “Temos de continuar o trabalho de literacia digital, que temos vindo a fazer, para reforçar as competências digitais dos alunos”, sublinhou.

Agora, nas últimas respostas ao Observador, volta-se a referir este ponto, defendendo que “a diferença de resultados entre a prova em papel e a prova em digital suscita questões importantes e que merecem a mais cuidada reflexão”, assumindo-se que, centrados nos resultados de 2021 do PIRLS digital, “a diferença para o papel (bridge) é de facto significativa, como referido na conferência de apresentação” de 15 de maio.

“Não obstante ser de admitir algum poder explicativo desta diferença, decorrente da forma de construção da prova digital, a mesma não deixa, naturalmente, de sinalizar a necessidade de dar continuidade ao investimento que tem vindo a ser feito neste âmbito, devendo Portugal — em linha com o compromisso firme deste Governo e com o trabalho já realizado — continuar a acompanhar a transição para o digital que todos os países estão a fazer”, conclui o gabinete de João Costa.

Por que motivo se deu tanto ênfase ao resultado em papel?

Se os resultados oficiais são os 520 valores, e não os 528 obtidos por quem respondeu em papel, por que motivo este número foi tão enfatizado? O argumento do Ministério da Educação é que as duas amostras — digital e bridge (papel) — são “estatisticamente equivalentes”, “igualmente robustas independentemente da sua dimensão,” e os cálculos dos resultados são “independentes e mutuamente exclusivos”.

Tudo isto, leva o ministério a considerar que são igualmente credíveis nos seus resultados, tornando-se possível uma comparação assente no mesmo modo de realização da prova (no caso, papel).

No entanto, numa segunda ronda de perguntas, assume que as provas não são equivalentes. “Não estamos, de facto, perante ‘provas equivalentes’ (uma é em formato digital e a outra em formato papel), mas sim perante duas amostras estatísticas igualmente representativas, e portanto igualmente válidas para proceder a análises e comparações de resultados. Ou seja, equivalentes em termos de representatividade e validade.”

Daí o ênfase dado aos valores do papel. “A opção pela comparação dos resultados em formato papel (em 2016 e 2021) resulta de um critério claro e lógico: quando se pretende comparar a evolução dos alunos portugueses em literacia de leitura recorre-se – porque possível – a uma comparação no mesmo formato (papel).”

Assim, atendendo a que, em 2016, a prova principal foi realizada em papel, o Ministério da Educação entende que o seu resultado pode ser comparado com o resultado das provas em papel realizadas em 2021, “sem prejuízo, naturalmente, de assumir a relevância dos resultados das provas realizadas em digital em 2021”.

Por último, o gabinete de João Costa recusa que tenha dado destaque aos dados em papel. “Importa reiterar que não houve ênfase dada apenas uma parte dos resultados. Foram todos apresentados e todos comentados. Como o ministro teve oportunidade de explicitar, tanto na sessão como no artigo de resposta publicado no Observador, a sua surpresa decorreu de, em termos de comparabilidade, ser expectável uma queda mais acentuada após os dois anos de pandemia.”

O artigo de resposta de João Costa ao texto de opinião de Alexandre Homem Cristo

O ministério argumenta ainda que caso se opte por comparar os resultados do PIRLS em 2016 (provas em formato papel) apenas com os resultados do PIRLS em 2021 (em formato digital), ignorando o bridge, está-se a introduzir um segundo fator (o formato das provas) na análise. “Por outras palavras, a evolução dos resultados passa a refletir não só a avaliação, em cada momento, das competências de literacia de leitura dos alunos, mas também as suas competências digitais (que influem no resultado a partir do momento que se opta por comparar valores de provas realizadas em modalidades distintas).”

E este é mais um motivo para o ministério se focar nos resultados em papel. “Ora, pretendendo o Ministério da Educação proceder, prioritariamente, à análise da evolução dos alunos portugueses em matéria de literacia de leitura (é esse, de resto, o objetivo do PIRLS), não faria sentido ignorar a variável do modo de realização das provas nessa análise.”

O modo é instrumental, argumenta-se na resposta, já que não são as competências digitais que o PIRLS pretende avaliar. “Foi nosso entendimento que seria mais completa uma análise que comparasse os dois modos”, aproveitando para analisar a relação dos alunos com provas em formato digital. “E deste ponto de vista sim, a diferença de resultados entre a prova em papel e a prova em digital suscita questões importantes e que merecem a mais cuidada reflexão”, completa o Ministério da Educação.