Índice

Índice

“É uma altura perigosa. Daqui para a frente temos de ser mais vigilantes em relação ao que vemos na internet.” No ecrã, a frase era dita por alguém com o rosto de Barack Obama, mas que não era o ex-Presidente dos EUA. As palavras pertenciam, afinal, ao realizador e ator Jordan Peele e aquele Obama não existia – era um vídeo manipulado com recurso a inteligência artificial (IA), um deepfake.

Rijul Gupta tem ainda hoje esse vídeo na memória. “Foi o primeiro dia em que vi um vídeo deepfake”, explica durante uma videochamada com o Observador. Enquanto engenheiro de aprendizagem automática já tinha visto muitos relatórios e trabalhos sobre o tema. Com aquele vídeo, que começou a circular nos fóruns especializados no fim de 2017, teve uma sensação diferente. “Lembro-me de o ver e de alguma coisa mudar, foi quase como um momento em que se acendeu a lâmpada na minha cabeça. Tive a visão de um futuro em que tudo podia ser falso, alguma coisa no Instagram, uma chamada da tua mãe… A sociedade depende de confiança, de responsabilização, e de se ver um vídeo do Presidente do país e acreditar que é real.”

Aquele vídeo foi o ponto de partida de Gupta para a criação da startup Deep Media, que desenvolve e fornece software de deteção de deepfakes para empresas, governos e jornalistas.

Desde que aquele vídeo do falso Obama se tornou viral, em abril de 2018, muito mudou. Nunca foi tão fácil e tão barato fazer um deepfake convincente – seja em imagem, em vídeo ou em áudio. A culpa é da evolução da IA e da crescente concorrência entre empresas, que se esforçam para conseguir superar os feitos das rivais. Se por um lado, se destacam os efeitos positivos da IA generativa, também cresce a consciência de que há muitos riscos, desde a circulação de imagens e vídeos com conteúdos pornográficos até à desinformação em eleições.

“As fotos vão para a tua família.” Chantagem e manipulação de imagens por Inteligência Artificial

Gupta não tem dúvidas do impacto que os deepfakes vão ter em momentos eleitorais. “2024 é o ano das eleições deepfake, nos EUA e em todo o mundo. Há 65 países a passar por eleições este ano, incluindo a Índia, que é enorme. E estamos a ver grandes quantidades de desinformação a surgir”, avisa. O especialista reconhece que “a mente humana, mesmo que tenha evoluído ao longo do tempo, continua a levar a imagem e a voz a sério”. “É realmente difícil mudar algo que está tão enraizado nos nossos cérebros”. Mas vinca que “não podemos confiar nos humanos para se protegerem dos deepfakes, porque a IA é muito mais poderosa do que uma só pessoa”.

Anatoly Kvitnitsky, que criou a AI or Not AI, outra das startups que está a identificar deepfakes de imagem e áudio, relembra a desinformação que marcou as duas últimas eleições nos EUA, em 2016 e 2020. “Na campanha de 2016, uma pessoa com um nível de educação razoável conseguia identificar: ‘ok, isto não parece real’. Este ano, a mesma pessoa não vai poder confiar nos seus olhos.” A desinformação que os deepfakes vão gerar vai ser muito mais intensa, acredita. “Se se olhar para as campanhas de desinformação [de 2016], tudo vai parecer uma piada em comparação com as que aí vêm, devido à IA generativa.”

Afinal, o que é um deepfake?

O termo deepfake tem duas vertentes, explica ao Observador Mário A. T. Figueiredo, professor do Instituto Superior Técnico (IST). Primeiro, “deep, de profundo, no sentido em que é algo falso muito difícil de detetar” e pelo uso da “técnica de inteligência artificial, mais particularmente de aprendizagem automática e da chamada deep networks”, para conceber estas imagens e vídeos manipulados. As deep networks são usadas numa área chamada deep learning, ou aprendizagem profunda. A segunda parte da palavra, fake, representa a manipulação. “São imagens falsas, profundamente falsas, difíceis de distinguir da imagem real.”

As técnicas mais modernas para conceber estes conteúdos, em voga devido à expansão da IA generativa, “conseguem aprender o que é uma imagem ou um vídeo natural a partir de muitos exemplos”. Os modelos de geração de imagem Dall-E ou o Midjourney conseguem “manipular subtilmente, mantendo as características que fazem com que pensemos que são reais, mas mesmo assim mudando o conteúdo de uma imagem”. Por exemplo, mudar uma cara para a de outra pessoa, mas mantendo o aspeto natural da imagem. O que, no final, resultam em imagens manipuladas que geram confusão “porque não conseguimos distinguir se foi, de facto, obtida por uma câmara fotográfica, se é uma representação do mundo físico e real ou se foi gerada por um computador e resultado de uma IA generativa”.

Os últimos anos, marcados pelos avanços da IA generativa, têm resultado num “misto de sensações” em Mário A. T. Figueiredo. Por um lado, “é sempre admirável e espantoso do ponto de vista técnico aquilo que se consegue fazer”, por outro, vê com “preocupação” o tema da manipulação pelos “impactos que pode ter”.

Embora diga que “sempre houve manipulação — já nos anos 30, na época soviética, se apagavam pessoas de fotografias, que eram manipuladas com a tecnologia da altura –”, vê, no entanto, diferenças para os atuais tempos. “Baixou-se a barreira de entrada, que exigia, antes, algum profissionalismo e conhecimento das ferramentas”. Com o uso massificado, Mário A. T. Figueiredo considera que é “relativamente fácil criar deepfakes não de qualidade máxima, mas convincentes” ao ponto de serem partilhados por alguém menos atento.

Entra em cena o aspeto social e emocional, explica o académico. Se o deepfake explorar “algo que bate certo com alguma indignação” da pessoa que vê o vídeo ou a imagem, “baixa imediatamente o nível de espírito crítico” ao ponto de se partilhar uma informação que não é verdadeira. “Preocupa-me como se poderão, muito facilmente, criar imagens falsas de alguém ou colocar uma pessoa a dizer algo que, na realidade, nunca disse.”

Figueiredo acredita que a “ameaça principal não está na tecnologia, que obviamente tem vindo a melhorar e a tornar-se algo desafiante”, mas sim no “ambiente em torno das redes sociais e da facilidade com que as pessoas disseminam algo com pouco espírito crítico”.

Software aprende com milhares de milhões de deepfakes para saber o que caçar

Para Ben Colman, CEO da startup norte-americana Reality Defender, já não é suficiente ter humanos a tentar distinguir o que é real do que é uma imagem criada por IA. “Os conteúdos multimédia gerados por IA estão sempre a evoluir e a avançar” e até os membros da própria equipa já tiveram dificuldade em perceber se uma imagem era IA ou não. “Acreditamos que temos de deixar que seja a IA a apanhar a IA”, vinca.

A empresa nova-iorquina nasceu em 2021 e, no ano seguinte, integrou a fornada de inverno de startups incubadas na Y Combinator, em Silicon Valley. “Percebemos rapidamente e bastante cedo que, no âmbito da IA generativa, os deepfakes poderiam ser mal usados e uma arma”, explica ao Observador. No ano passado, a startup fechou uma ronda de 15 milhões de dólares (14 milhões de euros) para avançar na investigação de tecnologia para deteção, que vende a empresas na área dos media, setor financeiro e organismos governamentais.

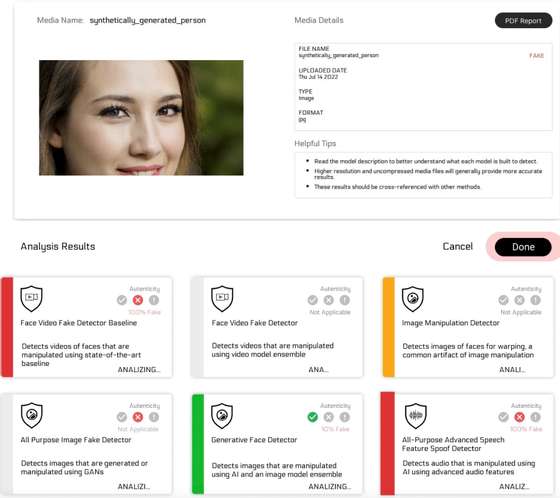

Um dos exemplos da ferramenta de deteção da Reality Defender

E como é que a IA anda à caça de deepfakes? A startup usa vários modelos de IA para avaliar imagens, vídeos e áudio. Assim, se “um modelo não detetar algo, outro poderá encontrar”, contextualiza o CEO. Os modelos podem apresentar resultados diferentes, mas é a partir “dos desacordos que são criados resultados mais completos e robustos sobre se algo é real ou não”, acredita. Quem usa o software da empresa recebe um relatório da análise com a indicação de percentagem de conteúdo real ou manipulado detetada por cada modelo.

A Deep Media é considerada uma rival da Reality Defender. Rijul Gupta indica que a empresa trabalha com o Departamento de Defesa dos EUA e aliados da NATO, mas não especifica outros clientes por questões de confidencialidade. Para fazer a deteção de vídeos manipulados “espelha um modelo de IA generativa” que, com recurso a “milhões e milhões de deepfakes e de imagens, vídeo e áudios reais”, aprendeu a distinguir o real do falso. “Quando alguém faz um upload para o nosso sistema, a nossa IA espelhada – ou adversária – vai ‘olhar’ para elementos como a luz, a sombra, o cabelo de alguém, a forma como as roupas se movem” à procura de “pistas subtis”. Feita a análise, o utilizador recebe a indicação sobre o estado do conteúdo, acompanhado de uma pontuação de confiança.

Mas as ferramentas destas duas empresas não estão disponíveis para quem quer fazer um uso pontual ou tirar uma dúvida sobre um determinado vídeo que viu numa rede social, já que só está acessível a quem pedir uma reunião e contratar o serviço. Há, no entanto, opções mais recentes no mercado, como a AI or Not e a ferramenta da organização não governamental TrueMedia, que podem ser usadas por qualquer pessoa, através de um site.

▲ Um dos exemplos da deteção feita na plataforma TrueMedia.org

É possível recorrer à AI or Not para confirmar rapidamente se uma determinada imagem ou áudio foi manipulado. A sua tecnologia para deteção foi apurada com “dezenas de milhões de imagens, tanto reais como geradas por IA”, explica o cofundador e CEO Anatoly Kvitnitsky, garantindo que “temos uma base de dados super curada de diferentes tipos de imagem”, com um foco mais intenso nas pessoas – o principal caso de uso. A tecnologia de deteção da AI or Not procura os “artefatos e padrões de pixéis” deixados por cada modelo de IA generativa. Seja o Dall-E, o Midjourney, ou outro modelo. Cada um “comporta-se de forma ligeiramente diferente”, deixando uma espécie de impressão digital nos conteúdos, diz Kvitnitsky.

Por agora ainda não tem deteção para vídeo, mas é algo que está nos planos, adianta o cofundador e CEO. “É uma equipa pequena, de seis pessoas, e há muito para fazer”, mas acredita que “será possível ter disponível no outono”, a tempo das eleições norte-americanas, que se realizam a 5 de novembro.

Já a TrueMedia, cuja versão beta foi disponibilizada este mês, surge de uma ideia do professor universitário e especialista em inteligência artificial Oren Etzioni, que também é fundador do Allen Institute for AI. Embora seja “um otimista em relação ao potencial geral” desta tecnologia, considera que “há trabalho a fazer para responder a diversos desafios”. “Estou profundamente preocupado com os desafios que os deepfakes apresentam e o impacto que podem ter em eleições.”

A ferramenta consegue analisar vídeos, áudios e imagens de várias redes sociais através da ligação ou conteúdos que sejam carregados pelo utilizador. Analisa diferentes aspetos e, em alguns minutos, transmite ao utilizador uma conclusão. Segundo Etzioni, a ferramenta foi treinada para fazer a análise através quer de “questões estatísticas” quer características mais localizadas do que está a ser submetido, como, por exemplo, lábios que se movem de forma incorreta. Uma vez que ainda está em modo de teste, só quem é aprovado pela organização é que pode sair da lista de espera e experimentar – algo que deverá mudar nos próximos meses. Por agora, “a reação tem sido positiva”, explica Etzioni. “Os novos utilizadores estão a vir de redações, de fact checkers e de organizações não governamentais.”

Marcas de água são uma solução “penso rápido”. É preciso legislação à altura do desafio

Apesar dos esforços para a deteção de elementos falsos, está em marcha uma corrida contra o relógio. E nem todos acreditam que as marcas de água sejam uma solução à altura do desafio trazido pelos deepfake.

Marcas de água visíveis, colocadas nos vídeos e imagens gerados por IA, ou invisíveis, só detetadas pelos computadores. O académico Mário A. T. Figueiredo refere que, mesmo as invisíveis, “não resolvem o problema da viralização” e disseminação de conteúdos manipulados. Acredita que essa responsabilidade de controlar os conteúdos “cabe às plataformas, as grandes empresas”.

▲ Nesta imagem gerada pelo Copilot da Microsoft, através do modelo Dall-E, é visível a marca de água no canto inferior esquerdo da imagem

“Os metadados e as marcas de água são boas para as pessoas, mas são facilmente removidas por quem queira desinformar ou enganar alguém”, explica Rajal Gupta, da Deep Media. “Francamente, são uma solução penso rápido. A maioria das pessoas compreende que se pode retirar facilmente uma marca de água”, contextualiza. “É como trancar uma porta – se alguém quiser mesmo entrar vai parti-la. [As marcas de água] fazem as pessoas sentirem-se melhor, mas não resolvem realmente o problema.”

Ben Colman, da Reality Defender, resume a questão a uma palavra: legislação. “Os locais onde as pessoas consomem e partilham conteúdos já têm proteções contra material de abuso sexual infantil ou imagens violentas, mas não contra conteúdos multimédia perigosos como os deepfakes ou os clones de voz. Isto precisa mudar antes de se chegar a qualquer progresso significativo”, alerta.

Tanto Colman como Gupta estiveram na semana passada numa audição no Senado norte-americano, focada no uso de IA durante as eleições. “Qualquer oportunidade para alertar para o problema dos deepfake – especialmente à frente de milhões de pessoas – é crucial para que tanto os cidadãos como os legisladores percebam o problema e os impactos”, refere Ben Colman.

IA vai tornar processos de autenticação com imagem e voz “completamente obsoletos”

Os especialistas não fazem alertas apenas para o impacto de deepfakes nas eleições, também temem as consequências em áreas como os serviços de autenticação. No setor financeiro, por exemplo, são usados processos KYC (know your costumer), que comprovam a identidade de um cliente através da voz ou da verificação de imagem.

A partir do momento em que há software que permite manipular a imagem ou fazer um clone de voz de alguém surgem as preocupações. Num teste feito pelo Wall Street Journal, foi possível ultrapassar o procedimento de segurança de um banco.

Anatoly Kvitnitsky, CEO da AI or Not, é dos que teme que os deepfakes possam ser usados para esse fim. Antes de estar à frente da empresa, passou uma década na área da verificação de identidade e combate à fraude. Já era investidor em startups de IA quando teve a experiência de “brincar” com o ChatGPT, lançado em novembro de 2022. Foi “um abrir de olhos” para o que aí vinha no mundo da IA generativa. “Percebi que o que costumava vender a clientes, os serviços de deteção de fraude, de autenticação, vão tornar-se obsoletos devido à IA generativa.” E conclui: “Já não se pode confiar nos nossos olhos e ouvidos. As comportas abriram-se para quem quer usar esta tecnologia para o mal.”