Os resultados dos alunos do ensino básico nas provas de aferição deste ano foram um desastre. No 8.º ano, a Português, 70% dos alunos evidenciou dificuldades (ou incapacidade) em responder às questões de gramática, e 67% as mesmas limitações na parte da escrita. Nas Ciências Naturais, o descalabro é quase total: 95% dos alunos revelou-se incompetente para responder na temática da “Terra no Espaço”, 84% na da “Terra em Transformação” e 81% na da “Sustentabilidade da Terra”. No 5.º ano, a História e Geografia, a Matemática e a Ciências Naturais, a paisagem não melhora: mais de metade dos alunos demonstra insuficiências, sendo que nas áreas científicas a média negativa ronda os 80%. Como é óbvio, “ninguém pode ficar tranquilo quando se tem um conjunto tão alargado de alunos que não está a aprender com qualidade”, como reconheceu o Secretário de Estado da Educação. Mas a questão fundamental está em definir como devem estes resultados ser lidos. Responder a esta pergunta não é fácil, mas é fundamental para perceber o seu significado. Vamos por partes.

Primeira parte: não é possível fazer uma comparação directa entre estes desempenhos e desempenhos passados. Isto é, os resultados destas provas de aferição não podem ser directamente analisados à luz do que aconteceu há dois, três, cinco ou dez anos. Porquê? Porque o governo assim o pretendeu. A decisão de alterar os anos avaliados com provas de aferição (2.º, 5.º, 8.º anos) teve precisamente esse efeito nefasto: quebrou uma série estatística que já tinha 15 anos de resultados comparáveis (nos 4.º, 6.º anos) e que havia atravessado vários governos desde 2001. Logo na altura, denunciei a opção. É que, a partir de agora, navega-se à vista: não se sabe ao certo se os resultados melhoraram ou pioraram, porque os resultados de anos anteriores referem-se aos finais de ciclo, e não aos actuais anos intermédios que o governo quer avaliar. Naturalmente, isso torna o escrutínio público muito mais difícil.

Ainda mais difícil ficou porque, para além de se terem aplicado noutros anos de escolaridade, o Ministério decidiu igualmente abolir as notas nas provas de aferição. Assim, em vez de um resultado quantificado numa escala de 1 a 5, o relatório do IAVE divide os alunos por segmentos – “conseguiram responder”; “conseguiram responder mas podem melhorar”; “revelaram dificuldade”; não conseguiram responder”. Traduzindo: quando, em 2018, os mesmos alunos fizerem o exame do 9.º ano, a comparação directa dos resultados será inviável.

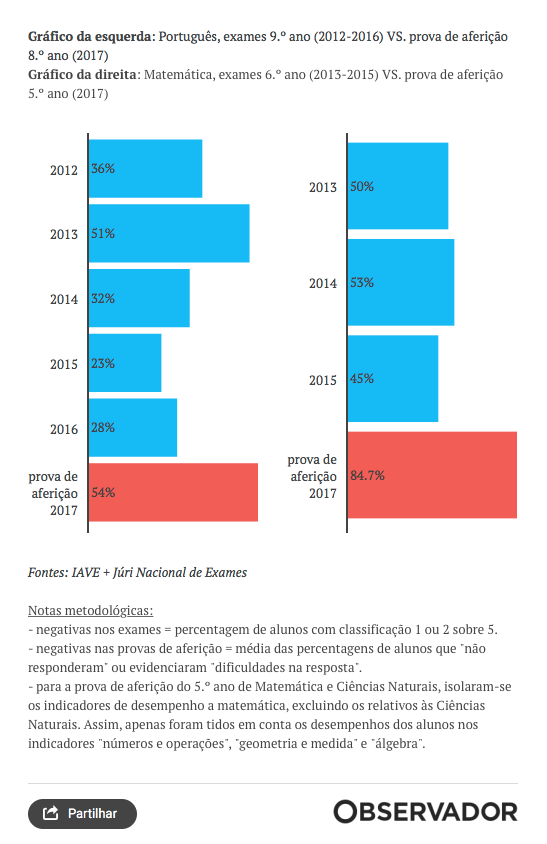

Isto não significa que seja impossível avaliar os resultados das actuais provas de aferição. E é aqui que começa a segunda parte da questão: se não dá para fazer uma comparação directa, faça-se uma indirecta. O exercício é simples. De um lado, os resultados das novas provas de aferição (5.º e 8.º anos) convertidos em médias positiva/negativa. De outro, e nas mesmas disciplinas, os resultados dos exames de 6.º e 9.º anos nos últimos anos (2012-2016) também divididos por médias positiva/negativa. A comparação não é perfeita – não somente pela necessidade de ajustar os indicadores da classificação como por estes se referirem a anos lectivos distintos, embora seguidos. Mas, como se vê no gráfico, expõe uma discrepância tão expressiva e brutal que não pode deixar de ser significativa para a reflexão: a percentagem de alunos com negativa nas novas provas de aferição é inesperadamente elevada e corresponde, sensivelmente, ao dobro das percentagens de negativas nas edições mais recentes dos exames. Sabendo-se que estes momentos de avaliação distam de apenas um ano escolar e avaliam o mesmo tipo de conhecimentos, algo não bate certo.

Ora, o problema resume-se assim: a fiabilidade das novas provas de aferição ficou em causa por apresentar resultados tão longínquos dos exames finais de ciclo (que o sistema educativo reconhece como referência para a medição das aprendizagens). Haverá várias explicações plausíveis para o sucedido. A mais provável, tendo em conta a investigação na área, é esta: a comunidade educativa (alunos, pais e professores) não terá atribuído o devido valor às novas provas de aferição e nelas não terá investido o seu esforço – porque não contaram para a classificação final, porque não envolveram sequer divulgação de notas e porque foram aplicadas fora dos anos finais dos ciclos do ensino básico. Ou seja, mesmo que tecnicamente perfeitas na sua concepção, se ninguém leva as provas de aferição a sério, não só os resultados tendem a ser inferiores como não reflectem o real conhecimento adquirido pelos alunos nas diferentes disciplinas. É muito provável que isso tenha acontecido neste caso.

Esta leitura diz, portanto, que os resultados das provas de aferição parecem ter um problema de fiabilidade. E isso acarreta duas consequências. A primeira é boa: se calhar o desastre dos resultados nas provas de aferição não é assim tão preocupante, porque diz mais acerca da irrelevância destas provas de aferição do que sobre insuficiências no processo de aprendizagem entre professores e alunos. A segunda consequência é má: face à dúvida quanto à fiabilidade destas provas de aferição, torna-se imprudente tirar conclusões ou tomar decisões sobre orientações de políticas públicas com base nos seus resultados. Excepto uma: a decisão política por provas de aferição, nos moldes em que o Ministério da Educação a tomou (alterando disciplinas, anos escolares e registos de avaliação), foi um grande erro. Um erro que estes resultados apenas vieram confirmar.