No artigo de opinião com o título «Os três problemas dos exames nacionais», publicado no Observador do passado dia 30 de maio, o autor afirma que os exames «Quase só avaliam a memória, não medem as aprendizagens de forma fiável e estão obcecados com as médias de acesso à Universidade». E levanta uma questão: «Como podemos melhorar os exames?», à qual acaba por não responder.

Não discutimos opiniões, obviamente, mas não podemos ficar indiferentes à metodologia usada para identificar os referidos três problemas. Uma opinião, ou é corretamente alicerçada em factos, ou é apenas mais uma opinião, entre muitas, que sobre a educação estamos habituados a ler e ouvir. Mas quando, ainda que com a melhor das intenções, o que admitimos ser o caso, uma opinião distorce a realidade de forma profunda transforma-se numa ferramenta cujo uso gera prejuízos aos quais não podemos ficar indiferentes.

Comecemos pelo lado positivo. O autor identifica, e bem, um problema crucial do nosso sistema de ensino. Um «triângulo que não funciona»: currículo (do ensino secundário); acesso ao ensino superior; aprendizagem relevante dos alunos no contexto atual (no quadro do que se preconiza no Perfil dos Alunos à Saída da Escolaridade Obrigatória ou de acordo com as recomendações da OCDE em matéria de ensino no horizonte 2030). Quanto a este aspeto, não podíamos estar mais de acordo: é urgente repensar o currículo, a forma de acesso ao ensino superior (que pode continuar, ou não, a usar resultados dos exames nacionais, mas nunca da forma como hoje se faz) e, mais difícil, muito mais difícil, o que de relevante se deve ensinar aos alunos, como fazê-lo, e como estes devem posicionar-se perante a aprendizagem e o «estudo». Discutir de forma construtiva estas questões é uma urgência educativa nacional, em nossa opinião, mas não é aqui nem agora que o iremos fazer. Fica apenas o desafio.

Vamos então aos problemas identificados e à forma como se sustenta, em regra erradamente, a sua existência.

Primeiro problema: Os exames «definem como objetivo da aprendizagem a memorização de informação».

- Para defesa da sua tese, o autor analisa dois exames nacionais do ensino secundário: História e Filosofia. Duas provas entre 22 exames nacionais que o IAVE publica todos os anos. Mas, não bastante, quantifica o «peso» da valorização da memória recorrendo a uma análise baseada no tipo de itens que são usados em cada prova. Nada de mais errado para aferir os domínios cognitivos que são avaliados. Não é o tipo de itens que determina a natureza das aprendizagens que são testadas, mas sim os estímulos que suportam os itens, a própria formulação das questões e o que se espera (critérios de classificação) das respostas dos alunos. Ora, os exames são concebidos de forma a testar um leque diversificado de domínios cognitivos, onde se inclui o necessário recurso à memorização, é certo, mas nunca excluindo dimensões associadas a aprendizagens mais significativas, como a compreensão, a análise, a capacidade de fazer inferências e explicar fenómenos ou factos a partir das mesmas, a capacidade de síntese, ou a resolução de problemas (quando aplicável), entre tantas outras.

- Essas dimensões são o reflexo de uma matriz que sustenta a conceção das provas, que por sua vez reflete o que se preconiza como dimensões centrais da aprendizagem em cada programa. O IAVE não pode «inventar» exames e concebê-los como lhe apetece. Obedece a uma carta de solicitação que, também ela, está vinculada a uma coerente articulação entre programas/currículo e objetos de avaliação.

- Os exames são todos escrutinados por diversos especialistas, passam pelo crivo de um conselho científico que integra os representantes das associações de professores e sociedades científicas que os validam. Isto quer dizer que estão alinhados com os programas, são representativos do que deve ser ensinado e aprendido. Retomaremos adiante a noção de validade dos resultados, conceito central no processo de avaliação.

- Porque os exames têm como objeto de avaliação os programas das respetivas disciplinas, medem, em percentagens variáveis, também domínios cognitivos que não apenas a capacidade de memorização, ou melhor, a capacidade de reproduzir conhecimento factual ou declarativo. E a percentagem de itens que convocam aprendizagens significativas e mais complexas, em regra, é superior a 30% da pontuação total, podendo mesmo ser bem mais próxima de 60%, em alguns casos.

- Mas, mesmo quando se avalia apenas a reprodução de conhecimentos, observam-se situações em que o desempenho médio dos alunos é manifestamente deficiente (vd. Relatório Nacional 2010-2016 – Exames Finais Nacionais do Ensino Secundário). Em boa verdade, a principal razão da mediania dos resultados das provas nacionais explica-se, em grande parte, pelas crónicas dificuldades que os alunos manifestam nas respostas aos itens que requerem aprendizagens significativas devidamente consolidadas. E esse não é um problema apenas evidenciado nas provas nacionais, mas também um dado observado nos testes internacionais, como adiante se ilustrará.

- Ou seja, se inadvertidamente, sem atender aos programas ou aos contextos de ensino e de aprendizagem que hoje conhecemos, o IAVE apostasse num reforço desmesurado de itens que mobilizassem aprendizagens significativas os resultados nacionais seriam seguramente inferiores, muito inferiores aos que se têm observado. Poderíamos ter uma «hecatombe» nacional, o que também nunca seria reconhecido como válido.

- E, ainda que, hipoteticamente, fosse esse o objetivo, qual o alinhamento com outras avaliações, mesmo as internacionais? De facto, mesmo as provas internacionais mobilizam conhecimento de conteúdos, como o PISA. Embora o contexto em que tal é feito seja diferente num teste PISA e num exame nacional, por razões óbvias que se prendem com os referenciais de suporte a cada uma das avaliações, não há manifestação de competências complexas sem conhecimento factual, mesmo que este esteja apreendido de forma a potenciar procedimentos de pesquisa avançada com recursos a novas tecnologias ou outras. Por isso, não é despiciendo ter nas provas nacionais itens que mobilizam conhecimento de conteúdos; apenas seria se só avaliassem esta dimensão, e não outras, o que não corresponde à verdade (e as provas, todas públicas e disponíveis para consulta em www.iave.pt são disso a prova irrefutável).

- Chegamos então à questão da validade. O conceito é complexo e com diversas dimensões, que não cabe aqui abordar. De forma simplista, acessível à generalidade dos leitores, a validade dos resultados (e não da prova) é, no final, uma representação social: é o reconhecimento pelos professores, associações e sociedades científicas do Conselho Científico, alunos e famílias, universidades e até pelo mercado de trabalho, em suma, por toda a sociedade, em geral, que os resultados, mesmo quando a nível de cada indivíduo são menos positivos, refletem o estado do ensino e da aprendizagem em cada momento, tal como ele entendido pelos cidadãos.

- E é essa procura de validade que leva o IAVE a ajustar tecnicamente o grau de dificuldade de algumas provas, seja pela necessidade de as ajustar a atualizações dos documentos curriculares de referência, seja pela necessidade, concertada com os parceiros técnicos e científicos, de tornar mais válidos os resultados. Por exemplo, recentemente, foi o que se observou nos exames de Matemática A e de Física e Química A.

Segundo problema: «As classificações dos exames nacionais suscitam dúvidas quanto à fiabilidade na medição das aprendizagens – como se explica que algumas disciplinas tenham sucessivamente médias e medianas negativas quando, entretanto, as avaliações internacionais apontam para melhorias consolidadas?»

A resposta é simples: explica-se, sim, e por variadas razões.

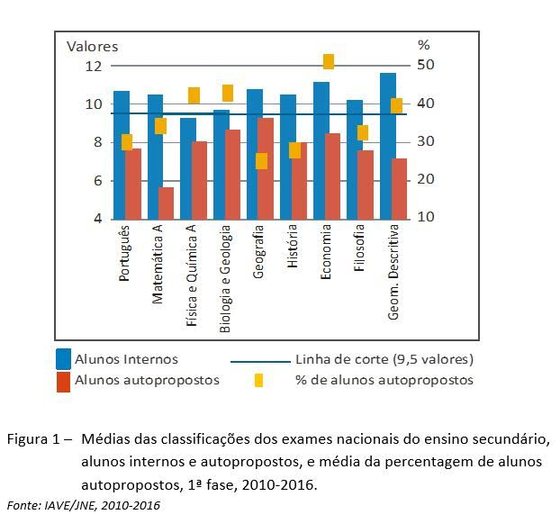

- Primeiro, as médias e medianas não são, em regra, negativas. Como explicitado inúmeras vezes, em relatórios nacionais e na imprensa, a análise dos resultados nacionais não pode ignorar a distorção que a inclusão dos resultados dos alunos autopropostos gera. Por isso, é desaconselhado usar como medida os resultados totais: estes alunos, cujo peso percentual no universo de alunos que realizam os exames não só é variável de disciplina para disciplina como entre cada ano, apresentam resultados francamente negativos, como seria de esperar, pois a maioria está, à partida, em condições de reprovação. Ao invés, os resultados dos alunos internos são os que espelham o desempenho dos alunos cujos professores validaram o seu «acesso» ao exame. A maioria dos outros alunos revela desempenhos muito fracos em contexto de avaliação interna, pelo que só como autopropostos podem candidatar-se aos exames. A figura 1 ilustra, nos últimos 5 anos, o panorama dos resultados médios nacionais e o efeito que a inclusão dos resultados dos alunos autopropostos provoca nas análises globais. Para 9 das disciplinas mais procuradas, apenas a Física e Química A apresenta uma média negativa (9,3 valores), mas já com resultados positivos em 2015 e 2016, o que decorre não de uma melhoria dos desempenhos dos alunos mas dos ajustamentos na conceção dos exames que atrás se referiram.

- Naturalmente que se pode argumentar que os alunos autopropostos, estando no sistema, devem ser considerados. Mas, em boa verdade, alunos internos e autopropostos constituem grupos distintos, pelo que a média dos resultados (ou mesmo a mediana) não são as medidas mais adequadas para caraterizar o universo de alunos do ensino secundário: aqueles a quem a escola não valida a candidatura a exame são, em primeira mão, o fruto de um acumular de fragilidades de aprendizagem que não raras vezes já são visíveis no final dos primeiros anos de escolaridade e, em especial, no fim do 1º ciclo. São as fragilidades que, conhecidas precocemente e não corrigidas, se perpetuam ao longo de todo o percurso escolar. É verdade que o IAVE poderia, na conceção das provas, ajustar o seu grau de complexidade para que a média de todos os alunos fosse positiva. Fazer provas que possam gerar uma média de 11, de 14 ou de 6 valores é apenas uma operação de natureza técnica. Mas tal seria visto como uma medida de facilitismo, ou de excessivo rigor, que nunca respeitaria princípios de validade aceites pela sociedade.

- Referir a falta de fiabilidade dos exames nacionais no final do ensino secundário com os argumentos usados no artigo enferma, por seu lado, de múltiplos equívocos que é forçoso elencar.

Primeiro: A incapacidade de resistir à tentação fácil de comparar resultados de provas nacionais com resultados de estudos internacionais. Este hábito, aliás praticado por inúmeros interlocutores, deve, de uma vez por todas, ser erradicado. Quaisquer comparações deste tipo revelam não se conhecer minimamente aspetos técnicos dos dois tipos de avaliações.

Os testes internacionais são provas não públicas. Por isso são constituídos, no essencial, pelas mesmas questões desde a sua primeira aplicação (por exemplo, o PISA, em 2000, ou o TIMSS, em 1995). Ou seja, estamos perante o mesmo instrumento de medida, aplicado repetidas vezes. O objeto de avaliação é o mesmo: avaliam-se os mesmos constructos desde que se realizou a primeira prova. As provas nacionais são provas públicas. Todos os anos são feitos novos exames. São tendencialmente equivalentes entre si, ano após ano, mas não são iguais. Não podem ser. E, ao contrário dos testes internacionais, os exames nacionais são construídos tendo por referência programas, alguns dos quais vão sendo sujeitos a alterações mais ou menos profundas ao longo do tempo. Acresce que o IAVE vai também introduzindo nas provas melhorias, fruto das avaliações e críticas construtivas que todos os anos os seus parceiros lhe fazem chegar. Em suma, as provas nacionais, com o atual modelo, não podem ser instrumentos que possam ser usados para aferir a progressão da qualidade do ensino. Para isso, sim, servem os estudos internacionais.

Segundo: Os desempenhos nos testes PISA traduzem a capacidade de os alunos para mobilizar conhecimentos a partir de situações que pretende replicar contextos tão próximos quanto possível da realidade. Para um melhor entendimento do âmbito do que se avalia nestas provas recomenda-se a leitura do relatório nacional do PISA, publicado há alguns meses, em http://iave.pt/np4/310.html.

As avaliações nacionais, pelo contrário, estão ancoradas a uma matriz curricular e a programas que constituem os seus referenciais. O que se avalia em ambos os casos está centrado nas aprendizagens que os alunos realizam ao longo da vida, na escola e fora dela, mas numa análise mais fina, há aspetos na forma como os desempenhos dos alunos são evidenciados nas respostas que introduzem limitações concetuais e processuais na comparação.

Terceiro: Mesmo assim, admitindo que alguma ligação pode ser feita entre as duas avaliações, a metodologia usada deita por terra qualquer validade das conclusões. O PISA é uma prova para alunos de 15 anos. Embora o ano modal seja o 10º ano, no caso português, em 2015, cerca de 30% dos alunos com 15 anos ainda frequentavam o 3º ciclo (7º, 8º ou 9º anos). É o resultado da aceitação social de elevados níveis de retenção a nível nacional. Comparam-se, assim, resultados, em provas distintas, de alunos que frequentam entre o 7º e o 10º anos de escolaridade, no PISA, e alunos a concluir o ensino secundário, 11º ou 12º anos, no caso dos exames nacionais.

Quarto: Para ilustrar a aparente incongruência e falta de fiabilidade das provas nacionais, comparam-se resultados no PISA, em leitura, com os do exame de Português do 12º ano. Ora o exame de Português avalia, entre outros aspetos, conhecimento explícito de gramática, escrita (área em que cronicamente os resultados são fracos em todos os níveis de ensino, com percentagens de acerto pouco acima dos 50%), conhecimentos relativos a obras de leitura obrigatória, enfim, um objeto de avaliação significativamente diverso do que se avalia com uma prova PISA. Não há comparação possível.

Do mesmo modo, comparam-se resultados em Ciências, no PISA, com os resultados em Física e Química A. E a conclusão só pode ser a mesma: são duas realidades totalmente distintas. Para quem tiver tempo e quiser consultar os documentos de referência para o estudo PISA em ciências recomenda-se a consulta do Relatório Nacional do PISA 2015 e do programa da disciplina de Física e Química A (em http://www.dge.mec.pt/fisica-e-quimica-0): ficará sobejamente elucidado. O âmbito da avaliação em Ciências no PISA cobre áreas como a Biologia, a Geologia, a Geografia, também a Física, mas nunca é limitado a esta área específica. Poderíamos ainda acrescentar que os itens PISA de Ciências, pelo facto de avaliarem conhecimento que deve ser mobilizado para responder a situações concretas do quotidiano e de apelarem à capacidade de leitura e de extração de informação dos documentos consultados, apresentam um contexto de avaliação facilitador do desempenho dos alunos. Embora não sendo impossível usar nas provas nacionais itens com caraterísticas similares, o que de facto acontece, não pode um exame nacional estar unicamente construído dentro desse paradigma. Esta linha de argumentação é, naturalmente, extensível à área da Matemática.

Se há estudo que poderia, à primeira vista, permitir uma leitura comparada dos seus resultados com exames da área de Física e Química ou de Matemática seria o TIMSS Advanced, no qual os alunos portugueses tiveram um desempenho francamente promissor, mas ainda assim abaixo da média internacional. Poderia parecer mais coerente, mas nem essa opção se considera plausível, atendendo às caraterísticas particulares dos alunos que integram a amostra nacional no estudo em causa.

Quinto: Os resultados globais PISA, apresentados como suporte para as comparações, não desagregam os níveis de proficiência dos alunos nos domínios que mobilizam aprendizagens significativas. Se o fizessem, talvez fosse interessante constatar que a percentagem de alunos portugueses que, no domínio das ciências, alcançam o nível 5 ou superior é de apenas 7,4%. Estes níveis, 5 e 6, são os que requerem capacidades cognitivas avançadas (vd. Relatório Nacional do PISA 2015, p. 29); nos níveis intermédios, 3 e 4, encontramos a maioria dos alunos, 49,8%; mas, nos níveis inferiores (2 ou abaixo de 2) ainda temos 42,8%. Esta distribuição por níveis está muito alinhada com a distribuição dos resultados nacionais por classes de frequência, se os quisermos agrupar em categoriais equivalentes às atrás referidas. Ou seja, Portugal evidenciou uma significativa melhoria na redução da percentagem de alunos com níveis de desempenho mais baixos (-7,1% de alunos no nível 2 ou inferior, em 9 anos); mas ainda mostra um espaço para grande progressão no aumento da percentagem de alunos que possam alcançar os níveis mais elevados (5 ou superior, valor que cresceu 4,3%, em 9 anos). Aqui reside um forte ponto de convergência com os resultados das provas nacionais. Como o que foi reportado nos últimos 6/7 anos, em sucessivos relatórios nacionais (de todos os níveis e ensino), os resultados não «descolam» de valores em torno da linha de corte (50% no ensino básico e 10 valores no ensino secundário). Esta é não só uma realidade «aceite» passivamente pela sociedade, em geral, como reflete a crónica incapacidade de o sistema conseguir aumentar a percentagem de alunos com desempenhos significativos nos itens que precisamente mobilizam as aprendizagens mais complexas: capacidade de análise, de interpretação e explicação de fenómenos, resolução de problemas, sentido crítico, entre outras. E em todas as provas nacionais há itens que apontam nesse sentido e, invariavelmente, os resultados persistem em mostrar pouca ou nenhuma progressão. Ou seja, há uma melhoria que se faz sentir sobretudo ao nível dos alunos com mais dificuldades, cujos resultados vão sendo «menos negativos». Mas essa melhoria é menos expressiva em relação aos alunos que têm desempenhos de bom nível. Em suma, sem prejuízo das diferenças concetuais e processuais que as avaliações internacionais e nacionais suscitam na mobilização das aprendizagens, este é mais um dado que reforça pontos de concordância entre os dois tipos de avaliação, e não o contrário.

Sexto: Medir aprendizagens requer o uso de métricas que, podendo ser diferentes, têm, forçosamente, equivalências incontornáveis. A aprendizagem é uma realidade finita: medi-la tem um limite inferior (quando não se sabe nada) e um superior (quando se sabe tudo). Em boa verdade, estes limites são apenas uma representação estatística: ninguém «não sabe nada» e ninguém «sabe tudo». Mas quando, em contexto de provas e de avaliações, atento o facto de existir um corpus de conhecimento pré-estabelecido que serve de referência à medição que se pretende efetuar, podemos, ter um desempenho mínimo (igual a zero) e máximo (valor igual ao limite superior da escala). Já quando se agregam resultados, ou se analisam valores médios, afastamo-nos desses limites extremos e, tendencialmente, aproximamo-nos dos valores centrais da escala. No PISA, e nos demais estudos internacionais, a escala usada é de 1000 pontos; nas provas nacionais 100 pontos (ensino básico) ou 200 pontos (ensino secundário). Por regra, estas escalas de medida têm associada uma ou mais linhas de corte, sendo que a mais crítica é a que separa o que se entende ser um desempenho aceite como satisfatório e um outro que não cumpra esse requisito. Em linguagem comum, a diferença entre ter uma «positiva» ou uma «negativa». Esta fronteira está no ponto médio da escala (50 pontos, numa escala de 0-100, 100 pontos, numa escala de 0-200 ‒ embora por artifícios dos arredondamentos, na realidade nacional sejam 95 pontos, 9,5 valores, isto é, 10 valores). Também nos estudos internacionais há uma linha (ou melhor um intervalo de valores) que permite que os resultados de qualquer país se situem acima da média internacional, abaixo dessa média, ou apresentem um valor dentro da média internacional. A determinação daqueles valores não é tão imediata como no caso do valor da linha de corte nas avaliações nacionais (ser 50 ou 95 pontos, ou 10 valores, é uma convenção, existindo avaliações em que a linha de corte assume valores diferentes, 70 pontos, por exemplo). Não cabe aqui explicar a sua metodologia, mas, de forma simples, estar na média da OCDE começou por ser um valor de 500 pontos (a escala é 0-1000 pontos). Hoje a média é ligeiramente inferior (493 pontos, em Leitura, 490, em Matemática, e 493 pontos, em Ciências).

Em termos nacionais, Portugal foi sempre, no PISA, um «aluno» não muito distante da média. Considerando os anos em que cada domínio constitui o objeto central da avaliação e o último resultado (2015), o país passou de: 470 pontos, em Leitura (2000), para 498 pontos (2015, +28 pontos); 466 pontos, em Matemática (2003), para 492 pontos (2015, + 26 pontos); 474 pontos, em Ciências (2006), para 501 pontos (2015, +27 pontos). Foi um progresso importante, que é fundamental sustentar em futuras avaliações, mas foi também uma evolução muito positiva quando nos comparamos com o conjunto de países, em especial no contexto europeu. Em Matemática, entre 2003 e 2015, Portugal foi, a par com a Federação Russa, o país que teve uma evolução mais expressiva (+ 26 pontos), num conjunto de 7 países com evolução positiva; em Ciências, Portugal faz parte de um conjunto de 23 países europeus com uma evolução positiva dos resultados, entre 2009 e 2015, com mais 9 pontos.

Quando olhamos para o panorama global, no PISA 2015, verificamos que os países participantes, considerando todos os domínios, se distribuem num intervalo de pontuação entre um mínimo de 328 pontos (República Dominicana) e um máximo de 564 pontos (Singapura), em ambos os casos no domínio de Matemática.

Mas, se em vez de se usar uma escala com uma amplitude de 1000 pontos estivéssemos a usar uma escala de 100 pontos, como nas provas nacionais (ensino básico). Então, em 15 anos, Portugal teria subido 2,8 pontos percentuais, em Leitura, 3,8 pontos percentuais, em Matemática, e 4,2 pontos percentuais, em Ciências. Ou seja, em termos absolutos, os progressos observados na generalidade dos países (quando assim acontece, pois em muitos tem sido observados o contrário), são relativamente modestos. E esta não é uma realidade nacional, é um dado mundial. De facto, é importante ter presente que uma variação de 30 pontos no PISA entre dois ciclos (três anos) seria reportada internacionalmente como um enorme sucesso (ou retrocesso, conforme o seu sinal), mas, vista numa escala de 100 pontos, apenas traduziria uma mudança de 3 pontos percentuais em relação ao resultado precedente, algo que passaria despercebido e sem qualquer expressão mediática.

Em suma, Portugal pode ser caraterizado como um «aluno» cujo desempenho passou de um nível «medíocre mais» para «suficiente menos», numa linguagem que não é a nossa mas que torna mais claro para a generalidade dos leitores. Significa, repita-se, uma evolução positiva muito significativa, mas que não legitima, como frequentemente se pretende fazer querer, que haja, em relação aos resultados das provas nacionais, uma diferença digna de registo.

Portanto, em conclusão, os resultados médios nacionais não se afiguram tão desalinhados com o que nos mostram os estudos internacionais. Em termos nacionais, não podemos ter instrumentos que permitam estabelecer diacronicamente uma comparação da evolução do sistema, pela razão já apontada: as provas são públicas. O facto de os exames terem de responder a exigências programáticas, que se alteram, contribui para que os resultados apresentem oscilações anuais em ambos os sentidos, embora estatisticamente não significativas. Mas, tal facto, numa análise de médio prazo, centrada nas respostas a itens específicos (e não nos resultados), não impede a observação de algumas, embora ténues, melhorias, como a leitura atenta dos relatórios nacionais nos mostra.

Sétimo: Os gráficos usados para ilustrar a comparação entre resultados do PISA e exames nacionais distorcem grosseiramente a realidade. É algo que uma não adequada utilização das representações gráficas pode facilmente gerar, como é o caso. Quase telegraficamente: i) os gráficos apresentam dois eixos de ordenadas para medir o mesmo fenómeno – desempenhos dos alunos. Mas, as escalas, como se referiu, que deveriam por isso ser equivalentes entre si, não respeitam essa equivalência nos intervalos espaciais entre valores; não se identifica a origem e o limite superior dos eixos (ainda que com interrupções que se justificariam atentos os valores em presença) e não obedecem a um alinhamento horizontal das linhas de corte. Comparam-se resultados anuais (exames nacionais) com resultados trianuais (PISA). Ou seja, a conjugação destas opções técnicas gera no observador uma ideia totalmente distorcida da realidade.

Terceiro problema: «A dependência entre o acesso ao ensino superior e o ensino secundário (e os exames nacionais em particular) põe toda a comunidade educativa focada num modelo de “ensinar para o exame” – assim amputando qualquer margem de autonomia ou inovação pedagógicas nas escolas, pois o risco de prejudicar o desempenho dos alunos no exame é demasiado elevado».

É, de facto, um problema, mas não dos exames nacionais. O problema aqui é a apropriação, totalmente incorreta, que a generalidade dos professores, dos alunos e das famílias fazem desses instrumentos e dos seus resultados. É errada a forma como se condiciona o ensino. «Dar o programa» em função dos exames, em vez de ensinar. De facto, há muito que estão identificadas as fragilidades dos alunos, de todos os níveis de ensino em que têm sido aplicadas provas de avaliação externa. Estão reportadas em relatórios nacionais e de escola, com informação ao nível do item, solução ímpar a nível internacional. Mas, mais do que os resultados, que no caso em apreço têm de ser desvalorizados, é a análise por item ou por domínio de aprendizagem que deve nortear o planeamento de intervenções pedagógicas capazes de fazer a diferença.

Alguma investigação também já mostrou que estudar para o teste, ou para o exame, passando horas a fazer exercícios ou, pior, a memorizar a «matéria», não resulta, ou seja, resolve o problema imediato de ganhar algum à-vontade na resposta aos itens que mobilizam reprodução de conhecimentos, mas acrescenta muito pouco, ou mesmo nada, nas competências que é necessário mobilizar para interpretar, explicar, relacionar ideias ou conceitos, aplicá-los na resolução de problemas ou na avaliação de situações problemáticas, em novos contextos.

Voltamos ao início. Precisamente por as provas nacionais nunca terem abdicado de avaliar domínios cognitivos mais complexos, os resultados não mostram, de forma abrangente e transversal às sucessivas coortes de alunos, e no contexto do território nacional, alterações significativas.

E, para terminar, temos ainda de considerar um sistema de acesso ao ensino superior anacrónico, em que a vida dos jovens continua a estar, em muitos casos, presa por resultados que medem desempenhos à décima de ponto, como se a avaliação, as provas e a sua classificação fossem ferramentas de precisão, como um qualquer termómetro digital de alta precisão. Não, de facto não são, nunca foram nem podem ser. Mais ainda quando são públicas. E, por tudo isto, esta será uma excelente oportunidade para reforçar o debate em torno destas matérias, em regra inquinado por olhares menos informados e por uma concetualização da escola, do ensino, da aprendizagem, da forma de estudar e da avaliação que continua a estar presa no tempo, num tempo que foi o dos nossos avós, o que, no caso pessoal, equivale a dizer há mais de um século.

presidente do Conselho Diretivo do IAVE, I.P.