O engenheiro Blake Lemoine terá sido afastado pela Google por ter manifestado a crença de que o sistema LaMDA (acrónimo para “Language Models for Dialog Applications”) se tinha tornado senciente ou consciente. A história tem todos os ingredientes para se tornar numa cena de filme de ficção científica, e provoca discussões apaixonadas nas redes sociais, numa sociedade que cada vez se parece com o mundo fantástico de Gotham City.

Para ajudar o leitor a formar a sua própria opinião sobre se o sistema LaMDA é consciente ou não, é possível explicar, de forma bastante simplificada, mas essencialmente verdadeira, como fazer uma IA (Inteligência Artificial) como o LaMDA em três passos.

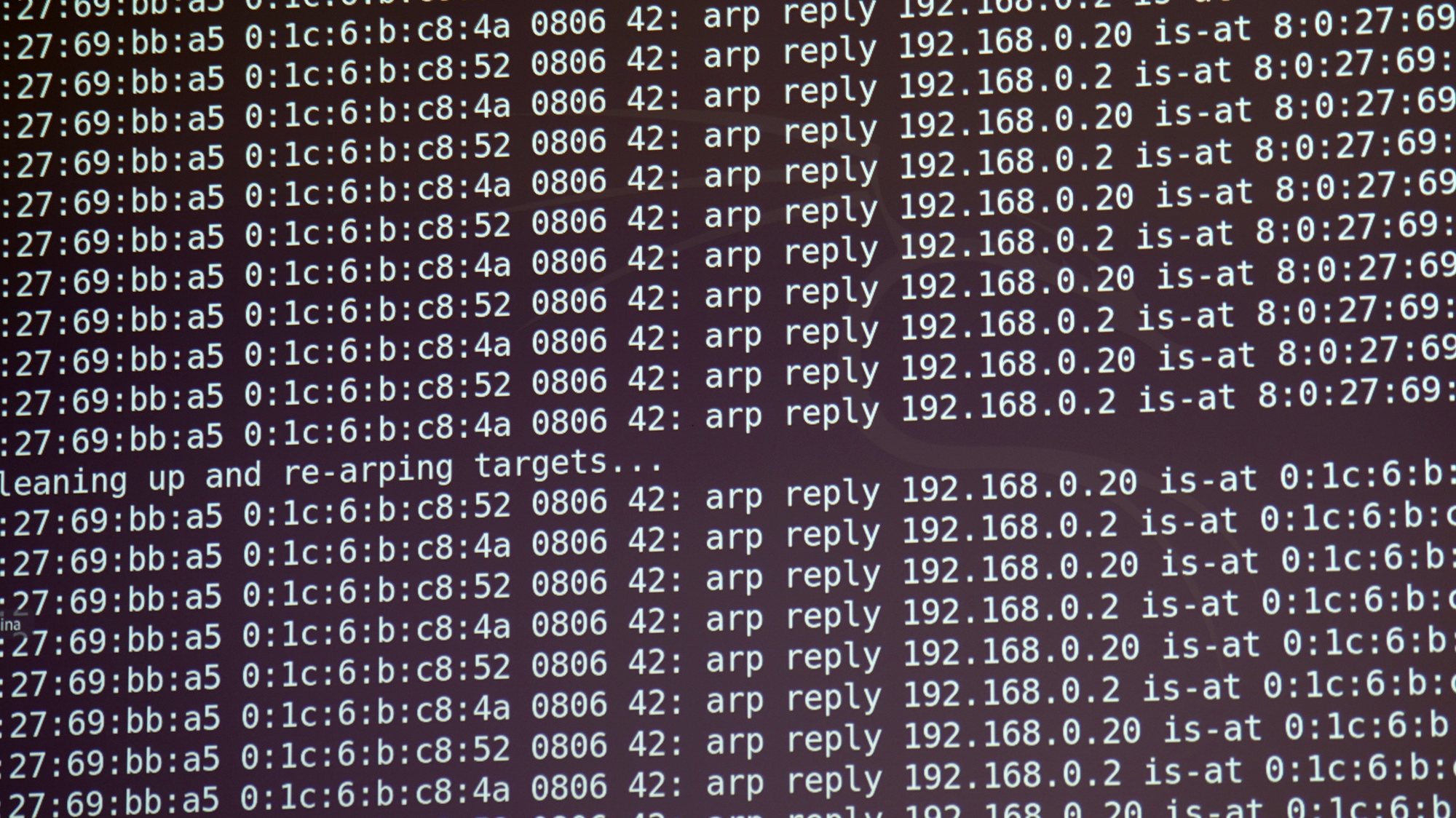

1. Primeiro, recolher uma enorme quantidade dos textos públicos extraídos de várias fontes, incluindo documentos, diálogos e conversações, notícias dos media, literatura, artigos da wikipedia, e muitos outros retirados da web. A este gigantesco arquivo digital chamamos o “corpus”. Recolhê-lo pode parecer um trabalho colossal, e é, mas a Google já armazenou e indexou nos seus centros de dados grande parte destes conteúdos ao longo de décadas. Por exemplo, o corpus usado pelo LaMDA totaliza mais de 1.5 milhões de milhões de palavras.

2. Depois, com base no corpus recolhido, há que construir uma gigantesca “tabela” que, para cada frase do corpus (com, digamos, menos de duzentas palavras) regista o conjunto das dezasseis frases que têm melhor ranking estatístico de lhe aparecer logo a seguir. Sim, esta tabela pode ser monstruosamente grande, e demorar bastante tempo a ser calculada e comprimida, mesmo em computadores super-poderosos. Este processo de construção chama-se “treino de rede neuronal” e consome muita energia. De facto, o treino de um modelo destes pode consumir a mesma energia que 140 lares durante um ano, mas, naturalmente, uma empresa como a Google não tem grandes limitações de recursos.

3. E pronto, já está! Para cada pergunta colocada pelo utilizador humano, a IA tem apenas que extrair da tabela gigante uma frase mais adequada para responder. Fá-lo-á com base nas entradas mais parecidas com a pergunta, e para continuar a conversa deverá repetir o processo. Pode também acrescentar-se alguns truques como, por exemplo, fazer com que a IA desvie o tema da conversa quando não existirem continuações adequadas com relevância significativa, ou então fazer com que a IA tome a iniciativa e faça uma pergunta para reenquadrar o humano. Para melhorar o desempenho do sistema, e despistar respostas sem sentido (por exemplo, num certo diálogo o LaMDA fala da “sua família”) o modelo pode ser afinado através de diálogos de treino com humanos como Blake Lemoine, ou recorrendo a pesquisas direcionadas a bases de dados específicas, para despistar erros factuais nas respostas.

Como nota final, deixa-se à opinião do leitor julgar se um sistema de software que essencialmente trabalha da forma estatística acima descrita, uma versão sofisticada de auto-completação de texto que explora correlações formais extraídas de textos pré-existentes, sem ter qualquer noção sobre o que está a falar, é consciente ou não.

Verdade, a explicação acima é uma simplificação grosseira das técnicas ultrassofisticadas de interpolação multidimensional chamadas de “aprendizagem automática” ou “aprendizagem profunda”, as quais constituem recentes e impressionantes avanços da Ciência Informática. Em 2019 foi atribuído aos inventores da aprendizagem profunda, Bengio, Hinton e Lecun o Turing Award, conhecido como o Prémio “Nobel” da Informática. Atualmente, esta tecnologia encontra aplicações de enorme impacto social, no reconhecimento de imagem, tradução automática, extração de padrões de informação em contextos diversos, diagnóstico médico, construção de chatbots e muitas outras. Mas, no presente, nada tem de consciente, ou mesmo de particularmente inteligente, por muito ilusionismo que possa oferecer, ou utilidade que possa apresentar. Podemos, pois, aguardar mais uns tempos pela Singularidade, que não está para breve.