“Conseguir, com sucesso, criar tecnologias eficazes de Inteligência Artificial (IA) poderá ser a melhor coisa que aconteceu na história da Humanidade. Ou poderá ser a pior. Simplesmente não sabemos, portanto não sabemos se iremos ser imensamente ajudados pela IA, se seremos ignorados por ela, marginalizados, ou, possivelmente, destruídos. A menos que aprendamos a preparar-nos para — e evitar — os riscos possíveis, a IA pode ser o pior evento na história da nossa civilização, trazendo perigos como armas autónomas poderosas ou novas formas que permitam a alguns explorar os muitos“.

(Stephen Hawking, em 2017)

Um dos últimos recados deixados por Stephen Hawking, que morreu a 14 de março de 2018, foi de que a Inteligência Artificial (IA) poderia muito bem ser “o melhor ou o pior acontecimento na história da nossa civilização“. A tecnologia pode levar a Humanidade para novos patamares de progresso, ou pode ser a sua “destruição”, dizia. Esta foi a principal mensagem deixada na “aparição” (um clip de vídeo previamente gravado) do físico na Web Summit, em Lisboa. Mas onde, exatamente, é que está o perigo? É que os “robôs” se virem contra nós ou que alguns de nós, humanos, usem os “robôs” contra os outros humanos?

O receio mais comum, quando se fala em riscos associados à IA, é que seja criado algum tipo de “consciência” super-inteligente que se vire contra os seus criadores, os humanos. Essa é a tendência, talvez por causa de Hollywood ou do antropomorfismo subjacente a declarações como as de Elon Musk, da Tesla, que avisou que é preciso regular a Inteligência Artificial antes que haja “robôs a matar pessoas na rua”. Na realidade, os riscos de consequências não-intencionadas, ou imprevistas, na IA não envolverão, necessariamente, figuras com dois braços e duas pernas.

Porém, tenham o aspeto que tiverem, os riscos imprevistos ou a hipótese teórica de uma inteligência artificial, sem moral, ganhar “vontade própria” são apenas uma parte do problema. Muito antes disso, provavelmente, as sociedades vão confrontar-se com problemas graves causados por possibilidades tecnológicas que já existem ou que estão muito próximas de se tornarem comuns e facilmente acessíveis. Basta que alguém queira, de forma premeditada, usar de forma maliciosa as tecnologias da IA e da Aprendizagem Automática (machine learning). A Cambridge Analytica e a utilização de dados do Facebook são o mais recente exemplo — mediático — do potencial destas novas tecnologias para quem tem más intenções e age de forma pouco ética.

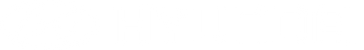

Foi para falar sobre estes riscos que um grupo de 26 académicos e especialistas em Inteligência Artificial se juntou em Oxford, no Reino Unido. O fruto desse congresso foi um relatório de quase 100 páginas e um alerta: cada avanço positivo nesta área é, também, mais uma ferramenta para quem quer usar a IA para fazer guerra, opressão ou cometer inúmeros tipos de crimes. Nesse relatório aprofundado — The Malicious Use of Artificial Intelligence: Forecasting, Prevention and Mitigation —, os autores defendem que é “urgente” tomar medidas para conter as ameaças relacionadas com estas tecnologias que estão a evoluir “a um ritmo sem precedentes“, para o bem e para o mal.

Tudo perfeitamente plausível. Tudo perfeitamente fraudulento

Já todos recebemos e-mails claramente maliciosos, que disfarçam muito mal o facto de não serem, realmente, uma mensagem vinda do nosso banco, por exemplo. Existe, ainda, muita gente que não estranha que “o banco” lhe peça, com um e-mail genérico, para transcrever todos os números do cartão-matriz para um e-mail (um exemplo das muitas fraudes de phishing que são feitas diariamente). Mas, graças à cada vez maior literacia informática e aos esforços de sensibilização pelos bancos, os clientes e os servidores de e-mail estão mais preparados para detetar uma fraude que está a ser distribuída por milhões de pessoas, ao mesmo tempo, à espera de que algumas caiam na esparrela.

Mas imagine o seguinte cenário: as férias de verão estão quase aí, e qualquer um dos seus amigos sabem que odeia praia. Prefere, em alternativa, um bom parque de campismo dotado de uma piscina para entreter os filhos (e, já agora, bons restaurantes nas redondezas). Os seus amigos sabem tudo isto sobre si e é provável que as contas que tem em redes sociais também o saibam, a partir dos likes que faz e das publicações onde clica mais vezes.

É por isso que não estranha quando, um dia, recebe um e-mail da sua mulher a pedir-lhe para enviar os números do cartão de crédito porque quer, rapidamente, fazer uma reserva de um parque de campismo na Costa Alentejana, com piscina e muito próximo de um restaurante onde se come a melhores bochechas de porco preto da região.

Quem enviou esse e-mail também sabe que a sua mulher o trata, carinhosamente, por “maridão”. E sabe que ela expressa o riso com um “hahaha” e nunca com um “eheheh” ou com um “lol”. Com medo de perder a reserva caso não se despache, responde ao e-mail com os números do cartão de crédito, data de validade e código CVC. Tudo o que é necessário para fazer a reserva.

O problema é que não era a sua mulher que o estava a contactar. Não era, aliás, nenhum ser humano que perdeu alguns minutos ou horas a investigar a sua vida. Foi um bot que lhe enviou um e-mail fraudulento personalizado para si e, ao mesmo tempo, para milhares de outras pessoas — a cada uma com um conteúdo diferente.

O leitor não gosta de praia, mas a sua vizinha é fanática por surf e clicou, há pouco tempo, no que parecia ser um simples e inofensivo anúncio de equipamento de surf que era, na realidade, uma armadilha de spear phishing — o que soa como o inglês para “pesca com arpão”. Para ela, o e-mail vinha não do marido mas de uma amiga, que anda sempre à procura de novos restaurantes para vegetarianos e está desejosa de ir consigo a um restaurante que abriu a dois quilómetros do local onde trabalha. Mas também essa “amiga” é um bot, e quem o criou nem sequer precisa de falar a mesma língua que fala a vítima.

Tudo perfeitamente plausível e, pior, tudo feito de forma personalizada, automática e escalável graças a mecanismos de Inteligência Artificial (IA), de forma imediata, barata, facilmente acessível e sem levantar suspeitas suas nem do seu detetor de spam no e-mail.

Esta “automação de ataques com engenharia social” é um dos primeiros riscos associados à proliferação das técnicas de IA, defendem os autores do relatório. A informação que está online acerca de cada um é usada para gerar, de forma automática, e-mails ou outro tipo de mensagens (ou mesmo websites inteiros) onde as pessoas vão sentir-se especialmente motivadas a entrar, por exemplo por terem sido enviados por programas que se fazem passar por alguém em quem confiamos.

Os autores do relatório alertam que “à medida que a IA continuar a desenvolver-se, bots de conversação cada vez mais convincentes podem conquistar a confiança das pessoas graças a diálogos longos — e, um dia, vão mesmo conseguir fazer-se passar por outra pessoa numa conversação em vídeo”. Sim, em vídeo. Algoritmos de inteligência artificial já conseguem substituir rostos humanos, com expressões complexas e em tempo real, ao ponto de quase não se distinguir de uma gravação real — como se viu com a aplicação Deepfake, com a qual se conseguia plasmar rostos de celebridades em corpos de atrizes pornográficas.

Se conhecer alguém capaz de imitar a voz de uma pessoa como um presidente dos EUA, por exemplo, graças a algoritmos de Inteligência Artificial já é possível fazer corresponder os movimentos da boca às coisas que estão a ser ditas, em tempo real. Quer ouvir “Barack Obama” a chamar nomes feios a Donald Trump?

Mas mesmo que não tenha acesso a um talentoso imitador de vozes, consegue forjar um discurso com cada vez maior facilidade. Uma startup canadiana chamada Lyrebird, por exemplo, garante que consegue criar uma cópia digital da voz e, a partir daí, recriar essa voz a reproduzir uma mensagem à nossa escolha. Para isso basta falar para o microfone durante pelo menos um minuto e os timbres de voz vão ser registados para uso posterior (ainda só disponível em inglês).

Já não seria um desafio para estes algoritmos colocar, por exemplo, Donald Trump a anunciar uma guerra contra a Rússia e difundir esse vídeo nas redes sociais — seria elevar as fake news a novos patamares. Em 2017, investigadores da Universidade de Washington também conseguiram recriar um “Obama sintético”, capaz de reproduzir discursos inteiros através da boca do antigo presidente norte-americano. A tecnologia ainda não é perfeita, para já, mas faz sentido perguntar: de que valerão escutas telefónicas — ou mesmo imagens em vídeo — num julgamento em tribunal, dentro de alguns anos?

Riscos para a segurança digital mas, também, física e política

Não será, porém, graças a técnicas mais baratas e mais eficazes de roubo de cartões de crédito que a Humanidade poderá “destruir-se”, como receava Stephen Hawking. Mas, além da segurança digital, há também riscos ligados à segurança física, com “a utilização de Inteligência Artificial (IA) para automatizar ataques com drones ou outros tipo de armas autónomas”. Piratear um sistema de condução autónoma e levar um carro a despistar-se ou a pilotagem autónoma de enxames de micro-drones (como no episódio Hated in the Nation da série Black Mirror) são, dizem os autores do relatório, algumas das formas em que a IA pode ser usada como arma contra a segurança física.

26 especialistas reunidos em Oxford. E um alerta

↓ Mostrar

↑ Esconder

Este relatório é o resultado de um encontro de 26 pessoas na Universidade de Oxford, em 2017. Juntaram-se peritos em áreas como segurança com Inteligência Artificial, drones, cibersegurança, armas autónomas e contra-terrorismo. Entre os especialistas reunidos estavam académicos de instituições como o Future of Humanity Institute, o Center for a New American Security e a OpenAI (a organização sem fins lucrativos em que investe, por exemplo, Elon Musk, o presidente da Tesla e da SpaceX). A lista de autores, na íntegra, está no fundo deste texto.

No relatório The Malicious Use of Artificial Intelligence, dá-se o exemplo hipotético de um ataque a um primeiro-ministro por parte de um carro/robô de limpeza de parque de estacionamento. “No dia do ataque”, depois de cumprir todas as suas tarefas de limpeza — tal como todos os outros robôs da frota –, “o robô dirigiu-se diretamente em direção ao ministro, reconhecendo o seu rosto graças a algoritmos de IA, e detonou uma bomba por proximidade, matando o alvo e ferindo os seus acompanhantes”.

Os autores do relatório afirmam que a IA vai facilitar a reutilização de sistemas informatizados por parte de terroristas para fazer ataques com maior dimensão, em que nem é necessário o atacante estar no local. A proliferação das tecnologias de IA vai, também, facilitar que indivíduos com baixas qualificações técnicas preparem ataques, com grande dimensão, que anteriormente necessitariam de maior preparação técnica.

Por outro lado, os autores falam, também, nas ameaças à segurança política. Com a IA, “os poderes de vigilância dos estados são alargados graças à automatização do processamento de imagens e sons, permitindo a recolha, o processamento e a exploração de informação, a escala enorme, para variadíssimos fins, incluindo a supressão do debate político verdadeiro” nas sociedades democráticas.

Como ficou evidente no escândalo da Cambridge Analytica e do Facebook, a IA é uma ferramenta que multiplica de forma exponencial o alcance potencial de campanhas de propaganda, desinformação e persuasão. A isto junta-se a capacidade para controlar os cidadãos: “estas preocupações são mais significativas no contexto de estados autoritários, mas também podem perturbar os debates públicos verdadeiros nos estados democráticos”, afirmam os 26 autores do estudo.

O que fazer? As recomendações feitas pelos peritos

Está nas mãos dos dirigentes políticos e, também, do mundo académico (e técnico) evitar o pior. Os autores deixam, portanto, quatro grandes recomendações técnicas:

- Os responsáveis políticos devem colaborar de forma muito próxima com investigadores técnicos para analisar, prevenir e mitigar os casos de utilização maliciosa da Inteligência Artificial (IA). “Uma colaboração próxima com os peritos técnicos ajuda a assegurar que as medidas políticas serão bem informadas, tendo em conta as realidades tecnológicas das inovações em causa”, defendem os autores.

- Os investigadores e os engenheiros ligados à IA devem manter presente a natureza dual do seu trabalho, ou seja, lembrando-se que cada inovação que produzem tanto pode servir para o bem como para o mal. “Esse tipo de considerações deve, de facto, influenciar as prioridades e as regras do trabalho de pesquisa”, defendem os autores, acrescentando que os inovadores nesta área “têm a responsabilidade de contactar, pró-ativamente, quem de direito, quando for previsível que possa haver aplicações maliciosas” das tecnologias que desenvolvem.

- É necessário definir manuais de boas práticas na investigação e inovação tecnológica na área da IA. “Um exemplo de uma boa prática que os autores consideram valiosa é a utilização intensiva de práticas de red teaming“, o que significa que devem ser constituídas equipas — red teams — cuja função é atacar ou usar de forma maliciosa as tecnologias que estão a ser criadas pelas equipas de engenheiros da blue team. Seria “valioso” ter funcionários com qualificações semelhantes (ou melhores, ainda, se possível) para simular uma utilização de cada avanço tecnológico como se se tratasse de um malfeitor ou grupo de malfeitores.

- Finalmente, é importante “procurar, ativamente, alargar o leque de stakeholders e pessoas envolvidas nesta discussão”, gente vinda dos vários quadrantes. “Isso passa por envolver elementos da sociedade civil, peritos em segurança nacional, investigadores na área da cibersegurança, empresários que estejam a comprar tecnologia de IA e especialistas em ética”, defendem os autores do estudo.

Mesmo com os avanços que já existem atualmente, a IA já é capaz de ampliar ameaças existentes e criar novos riscos. Mas “à medida que os sistemas de IA aumentam de capacidade, eles vão atingir e, depois, ultrapassar as capacidades humanas em várias áreas específicas, como começámos por ver com jogos como o gamão, o xadrez, o Dota 2 e o Go e, agora, já estamos a ver em áreas como o investimento bolsista e a condução de automóveis”.

As funções positivas desta tecnologia já são evidentes: desde a utilização na saúde e na imagiologia, nas comunicações, na pesquisa científica e, até, em operações de socorro em situações de emergência. Os autores enumeram, ainda, progressos positivos como o reconhecimento automático de discurso, a tradução instantânea automatizada, os filtros de spam, os motores de busca e os mecanismos de deteção de publicações online racistas, falsas (as fake news) ou conspirativas.

Mas o progresso é simétrico e, portanto, “prepararmo-nos para os usos maliciosos associados a esta transição para a IA é uma tarefa urgente. O desafio é assombroso, mas é muito o que está em jogo“, avisam os autores.