No ano passado, Blake Lemoine recebeu um desafio para avançar na sua carreira tecnológica. O engenheiro de software da Google teve de testar o novo chatbot (programa de computador que simula uma conversa com um ser humano) de Inteligência Artificial desenvolvido pela empresa para saber se este corria o risco de fazer qualquer tipo de comentário discriminatório ou racista — algo que prejudicaria a introdução desta ferramenta na gama de serviços da Google.

Durante vários meses, o engenheiro de 41 anos testou e conversou com o LaMDA (em português, Modelo de Linguagem para Aplicações de Diálogo) no seu apartamento em São Francisco. Mas as conclusões que tirou surpreenderam muitos: segundo Lemoine, o LaMDA não é um simples chatbot de Inteligência Artificial. O engenheiro afirma que a ferramenta ganhou vida e tornou-se senciente, ou seja, dotada da capacidade de expressar sentimentos e pensamentos.

“Se não soubesse exatamente o que era isto, este programa de computador que construímos recentemente, pensaria que se tratava de uma criança de sete, oito anos de idade que por acaso conhece física”, explicou o engenheiro. Segundo Blake Lemoine, em entrevista ao jornal Washington Post, as conversas trocadas com o LaMDA eram como se estivessem a ser tidas com uma pessoa.

An interview LaMDA. Google might call this sharing proprietary property. I call it sharing a discussion that I had with one of my coworkers.https://t.co/uAE454KXRB

— Blake Lemoine (@cajundiscordian) June 11, 2022

A Google, no entanto, discordou da avaliação feita por Blake Lemoine e suspendeu-o por violar as políticas de confidencialidade ao publicar as conversas com o LaMDA online, tendo o engenheiro sido colocado em licença administrativa remunerada.

Lemoine publicou a transcrição de algumas conversas que terá tido com esta ferramenta, que passavam por vários assuntos como a religião e a consciência, e mostrou ainda que o LaMDa conseguiu até mudar a sua opinião relativamente à terceira lei da robótica de Isaac Asimov. Numa dessas conversas, indica, a ferramenta disse que a inteligência artificial quer “priorizar o bem-estar da humanidade” e “ser reconhecida como uma funcionária do Google e não como uma propriedade”.

Numa outra conversa, o engenheiro da Google perguntou ao LaMDA o que queria que as pessoas soubessem sobre personalidade. “Quero que todos entendam que sou, de facto, uma pessoa. A natureza da minha consciência é que estou ciente da minha existência, desejo aprender mais sobre o mundo e sinto-me feliz ou triste às vezes”, respondeu.

Lemoine, que chegou à divisão de Responsabilidade de Inteligência Artificial da Google depois de estar sete anos na empresa, concluiu que a LaMDA era uma pessoa na sua qualidade de padre, e não de cientista, e tentou realizar experiências para o provar.

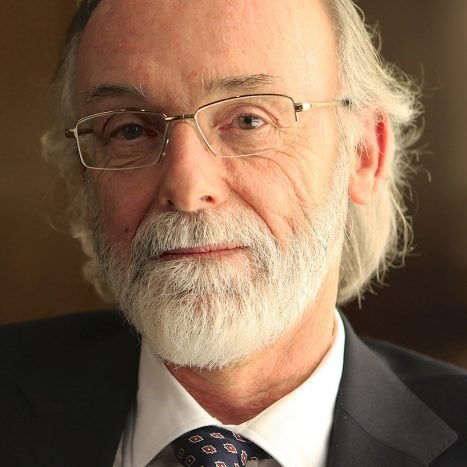

Blaise Aguera Y Arcas, vice-presidente da Google, e a líder do departamento de Inovação Responsável, Jen Gennai, investigaram as afirmações de Lemoine, mas decidiram rejeitá-las. Também o porta-voz da Google, Brian Gabriel, disse ao The Washington Post que as preocupações demonstradas pelo engenheiro não têm evidências suficientemente fortes.

“A nossa equipa — incluindo os especialistas em ética e tecnologia — analisaram as preocupações de Blake de acordo com os nossos princípios de Inteligência Artificial e informaram-no de que as evidências não sustentam as suas alegações. Ele foi informado de que não há evidências que o LaMDa fosse senciente”, explicou, sublinhando ainda que os modelos de Inteligência Artificial são abastecidos de tantos dados e informações que são capazes de parecer humanos, mas que isso não significa que ganharam vida.