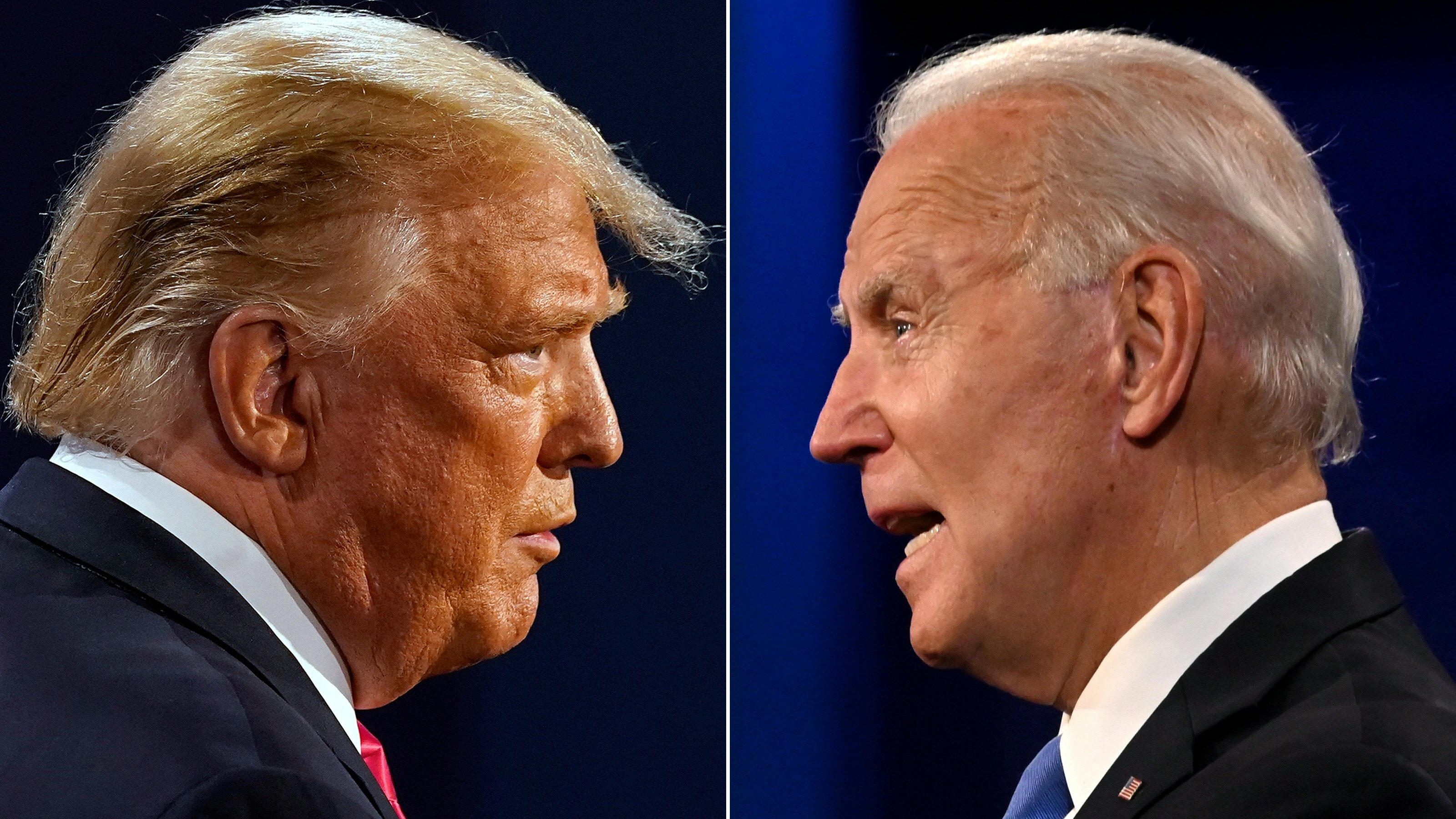

O consultor político dos EUA, Steve Kramer que trabalha para a campanha de um congressista democrata pouco conhecido, Dean Phillips, declarou ser o promotor de chamadas telefónicas automatizadas (robocalls) e falsificadas, usurpando a voz do presidente Joe Biden.

O telefonema gerado com inteligência artificial (IA) incitava os eleitores a não votar nas primárias do Partido Democrata, no Estado do New Hampshire, em janeiro, o que já motivou uma investigação por “tentativa ilegal de perturbar” um escrutínio.

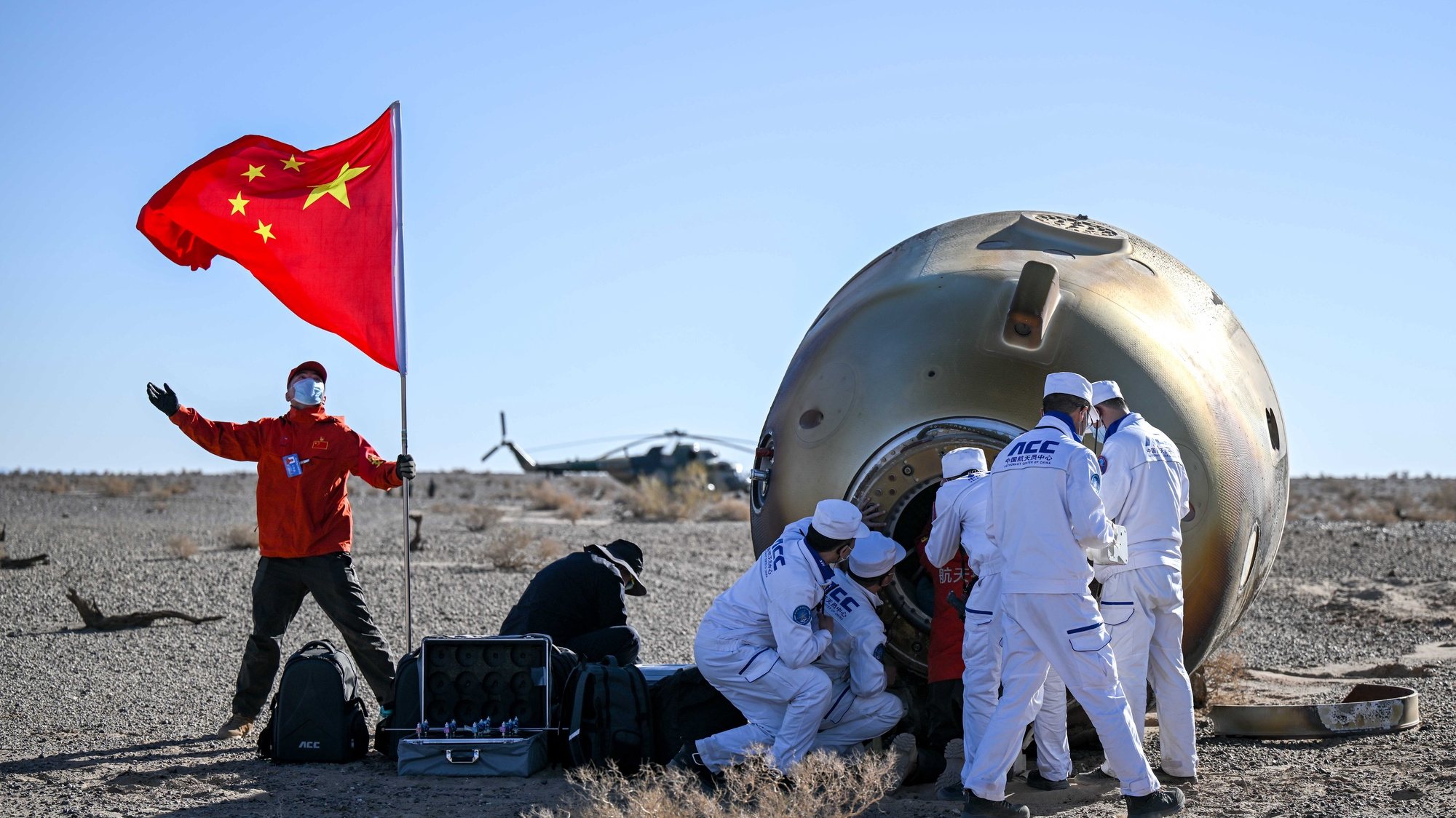

O incidente aumentou as preocupações de autoridades, analistas e associações, que receiam um crescimento acentuado de montagens de áudio e vídeo com fins de desinformação, durante as eleições presidenciais nos EUA e outras relevantes que vão ocorrer, em vários pontos do mundo, este ano.

Steve Kramer, um consultor contratado por Dean Phillips, um congressista eleito pelo Estado do Minnesota e candidato às primárias democratas, disse no domingo à NBC News que tinha contratado um mágico de Nova Orleães, Paul Carpenter, para imitar a voz de Biden, graças a um instrumento de IA. Adiantou que o caso tinha a intenção de chamar a atenção para os perigos que representa a IA em política.

“É uma oportunidade para mim de fazer a diferença. E foi o que fiz”, disse à NBC, acrescentando: “Por 500 dólares, fiz uma operação com um valor aproximado de cinco milhões de dólares, trate-se da atenção dos media ou da reação das autoridades”. A falsa mensagem telefónica, redigida por Kramer, começava com a afirmação “Tanto disparate!”, que é uma das favoritas de Biden. Kramer adiantou que as chamadas tinham sido feitas à revelia da campanha de Phillips. “Estou satisfeito que ele tenha confessado. Os EUA já deveriam ter proteções para impedir estas utilizações nefastas da IA”, declarou este candidato democrata nas redes sociais.

Glad he fessed-up.

America should already have AI guardrails in place to prevent its nefarious use.

The next generation of executive leadership must better anticipate and prepare for the future. https://t.co/ce5k0NioeD

— Dean Phillips (@deanbphillips) February 25, 2024

O consultor informou que já recebeu uma intimação do regulador das telecomunicações dos EUA [FCC, na sigla em Inglês] . No início do mês, a FCC decidiu proibir as chamadas automáticas efetuadas com vozes geradas por um programa de IA, devido às falsificações cada vez mais sofisticadas permitidas por esta tecnologia.