Índice

Índice

Palavras que à primeira vista não fazem sentido nas frases, códigos, emojis com duplo significado ou símbolos a substituir letras. Não é uma nova forma de falar, nem vai mudar o discurso como o conhecemos, mas é a internet a mostrar, uma vez mais, que tem uma linguagem muito própria.

Há influenciadores que acreditam que as palavras que utilizam nos vídeos afetam a quantidade de pessoas a quem os seus conteúdos chegam. Por isso, começaram a substituir determinadas palavras que creem violar as regras da moderação por outras menos óbvias. Esta prática é conhecida entre os norte-americanos como algospeak — um termo que resulta da junção das palavras ‘algoritmo’ e ‘falar’ (speak, em inglês).

Foi a forma que os criadores de conteúdo arranjaram para se adaptarem aos algoritmos, principalmente no TikTok, rede social onde ter muitos seguidores não garante, por isso só, que as publicações sejam vistas por um público amplo. Nessa plataforma, a principal forma de assegurar que os posts são vistos é através da página “For You”, que recomenda conteúdos aos utilizadores com base em publicações com que interagem.

Para conseguirem falar de temas como morte, suicídio ou distúrbios alimentares sem terem os vídeos removidos ou retirados da página de recomendações, os influenciadores recorrem ao algospeak, explica o The Washington Post. Ainda assim, se para alguns esta prática serve para ter a certeza que os conteúdos são vistos por um público amplo, para outros é meramente uma forma de brincar com as palavras.

Aqueles que acreditam que os seus vídeos foram removidos ou retirados da página “For You” por terem utilizados termos pouco amigáveis, de acordo com as diretrizes do TikTok, costumam dizer que foram alvo de “shadow banning” — um bloqueio fantasma, onde perder o destaque dos vídeos não é imediatamente visível.

“Pizza” para Pfizer ou “Unalive” para “morte”. O novo mundo do Algospeak

Para escapar à moderação que ‘caça’ termos que consideram proibidos, há criadores de conteúdos que nunca dizem ou escrevem determinadas palavras. Kayla Williams, por exemplo, nunca disse “suicídio”, apesar de utilizar o TikTok para falar sobre esse e outros tópicos relacionados com a saúde mental com os seus mais de 82 mil seguidores.

@bringmekayla Going strong at almost 300 days though #mhrecovery #shrecovey #fyp #mentalhealthawareness ♬ original sound - Comedy Fan

O receio de que os conteúdos não tenham destaque ou de vê-los serem removidos pelas redes sociais devido às palavras escolhidas começou com a pandemia. Para combater a desinformação relacionada com a Covid-19, as plataformas deixaram de promover os vídeos com palavras sobre esse tópico. A solução encontrada pelos influenciadores foi utilizar códigos. “The Vid”, “Panda Express” (nome da cadeia de restaurantes de cozinha chinesa) ou “Backstreet Boys reunion tour” foram alguns dos utilizados para falar sobre o coronavírus no TikTok.

No Instagram, os negacionistas da vacina começaram a chamar “swimmers” (nadadores) àqueles que se vacinaram e utilizavam a expressão “join a swim club” (aderir a um clube de natação) para descrever o ato de vacinação. Por sua vez, no Facebook, os grupos privados que se manifestavam contra a vacinação deixaram de permitir novos utilizadores e mudaram de nomes à medida que a rede social tentava impedir a proliferação de desinformação. “Dance party” (festa de dança) ou “Dinner party” (jantar de festa) são dois dos nomes eleitos, em alusão aos jantares e festas que deixaram de ser permitidos devido às restrições impostas nos mais diversos países.

Um administrador do “Dance party” fez uma publicação onde considerava que vencer o sistema de moderação do Facebook ao conseguir continuar a falar contra a vacinação era como se tivesse recebido “uma medalha de honra”, conta a NBC. Além disso, aproveitou para lembrar os utilizadores do grupo que não poderiam recorrer a “palavras não aprovadas”. E eles assim o fizeram. Quando uma mulher quis explicar que o marido tinha ficado doente após ter estado com pessoas que tinham sido vacinadas escreveu que ficou doente numa “viagem entre países onde passámos duas noites com dançarinos [‘dancers]”.

Há mais códigos utilizados nos grupos compostos por indivíduos contra a vacinação da Covid-19. “Pizza” ou “Pizza King” serve para se referirem à Pfizer e “Moana” à Moderna.

Mas é no TikTok que o fenómeno ‘algospeak’ ganha uma dimensão diferente, e é usado em vários contextos, que vão do conteúdo sexual à guerra na Ucrânia. De acordo com o The New York Times, as diretrizes do TikTok não mencionam quaisquer palavras proibidas, mas a consistência na eliminação de determinadas publicações levou os criadores de conteúdo a evitá-las. Estes são alguns dos códigos criados para os mais variados temas:

Para se referirem a mamilos, os norte-americanos deixaram de dizer ou escrever “nipples” e passaram a utilizar o termo “nip nops”.

Sexo passou a “seggs” ou “seggsual”.

As profissionais do sexo referem-se a si como “contabilistas” e usam o emoji do milho (que em inglês é corn) para substituir a palavra pornografia (porn).

“S.A.” em vez de “sexual assault” (abuso sexual).

“Unalive” (não vivo, em tradução livre) passou a ser utilizado para substituir a palavra suicídio, morte ou ainda para falar sobre os soldados mortos na guerra na Ucrânia.

“Cornucópia” em vez de homofobia.

P⭐️ é estrela pornográfica.

O “oposto do amor” (“opposite of love”) serve para substituir a palavra ódio.

“Leg booty” descreve aqueles que pertencem à comunidade LGBTQIA+.

Para falar sobre a guerra da Ucrânia, as pessoas começaram a utilizar um emoji de girassol para simbolizar esse país, que foi invadido pela Rússia em fevereiro.

“Acampar” ou “férias” são as expressões utilizadas para falar sobre aborto nos EUA depois de o Supremo Tribunal ter acabado, em junho, com o direito constitucional a esse procedimento médico. Além dessas palavras, muitos dos vídeos acerca do aborto tinham uma música de fundo: “Paris”, dos Chainsmokers, tornou-se um hino, de acordo com o The Washington Post, devido à frase “If we go down, then we go down together” (“se cairmos, então caímos juntos”, em português).

O TikTok diz que escrever ou falar sobre o aborto não é proibido na aplicação, mas chegou a assegurar que iria remover conteúdos que proliferassem a desinformação ou que violassem as diretrizes estabelecidas. Ainda assim, sempre que falavam sobre o tópico, os criadores de conteúdo evitavam dizer diretamente “aborto”. A medida chegou à política e o autarca da cidade de Waterville, Jay Coelho, publicou um vídeo sobre o tema onde escreveu que “acampar é legal no Maine”.

@therealmainemayor my daughter's have less rights than I do. #rowevswade #scotus #mistake #womenshealth #womensrights #abortionrights #abortionishealthcare #2ndclasscitizen ♬ Paris - The Chainsmokers

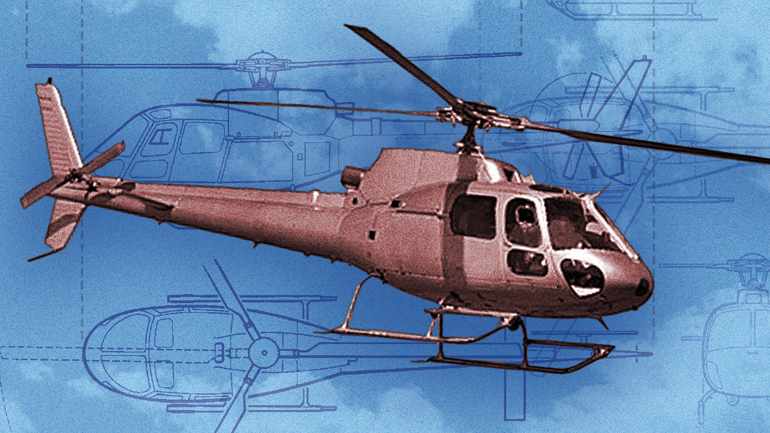

O caso do “suicídio” é diferente do do aborto porque sempre que os utilizadores pesquisam por essa palavra, o TikTok remete-os para linhas de ajuda: “Se tu ou alguém que conheces está a passar por um período difícil, aqui estão alguns recursos que podem ajudar”. A Wired refere que a hashtag “suicídio” não existe, mas que a hashtag “unaliving” tem 6,6 milhões de visualizações ou que a hashtag “unalivemeplease” tem 9,2 milhões.

O que aparece no TikTok quando os utilizadores procuram por “suicídio”

Além da substituição de determinados termos por outros e de emojis com duplo significado, há a inclusão de símbolos ou números no meio das palavras. Por exemplo, na palavra “lesbian” (“lésbica”) os criadores de conteúdo norte-americanos começaram a adicionar o símbolo do dólar (“Le$bian”). Isto aconteceu porque a ferramenta de conversão de texto para discurso do TikTok lê e pronuncia a palavra como “Le dólar bian”, o que evita que os vídeos que a incluem percam destaque.

Se na maioria das vezes a substituição de palavras é inofensiva, existem casos em que não se trata apenas de contornar o algoritmo. É algo mais sério, que, como relata a Forbes, mostra que as alternativas para escapar à moderação estão em constante evolução — o que representa um desafio para as tecnológicas e para as empresas que estas contratam para ajudar a fazer a verificação de conteúdos. A expressão “Pizza de queijo” parece inofensiva, mas em determinados contextos ganha um significado obscuro. No TikTok é utilizada por contas que oferecem a troca de imagens explícitas de crianças.

A empresa Telus Internacional, que fornece serviços de moderação de conteúdo para redes sociais — incluindo o TikTok — explicou à revista Forbes que não cabe a si determinar se os termos (como “Pizza de queijo”) são removidos porque as plataformas é que decidem as diretrizes a seguir. Contudo, recusou-se a divulgar se algum dos seus clientes já tinha removido alguns dos novos códigos.

Em declarações ao The New York Times, uma porta-voz do TikTok (cujo nome não é mencionado) sugeriu que os influenciadores estavam a exagerar e que muitos “vídeos populares” falam sobre sexo. Para comprovar o que estava a dizer, a mesma responsável enviou vídeos de pais que explicavam como falar sobre o tema com crianças.

A maioria dos norte-americanos já se deparou com algospeak. Geração Z é a que mais usa, revela estudo

↓ Mostrar

↑ Esconder

A maioria dos norte-americanos (59%) reconhece ter visto “algospeak” a ser utilizado nas redes sociais, meios de comunicação, sites de marcas ou comunidades de jogos.

Um inquérito realizado pela Telus International — e citado pela Bloomberg — a mil pessoas nos EUA percebeu ainda que 42% indicaram que a utilização de códigos aumentou desde que a detetaram pela primeira vez.

30% dos inquiridos admitiu já ter utilizado o algospeak, com o estudo a ter percebido que é mais comum entre a Geração Z (72%).

A “área cinzenta” das regras do TikTok

O TikTok, tal como as outras redes sociais, tenta remover o máximo de publicações sexualmente explícitas, que contribuam para propagar a desinformação ou que contenham discursos de ódio. “Qualquer conteúdo — incluído vídeo, áudio, livestream, imagens, comentários, links ou outros textos — que viole as diretrizes da comunidade” é removido. A rede social refere que os utilizadores são “notificados” das decisões e podem “recorrer” se acreditam não ter incorrido em nenhuma violação das regras.

Grande parte das publicações removidas têm tópicos que vão contra as diretrizes como violência ou nudez. Os criadores de conteúdo fazem de tudo para não perturbar o algoritmo e não terem as suas contas bloqueadas. Ainda assim, o The New York Times dá conta da existência de uma “área cinzenta” quanto às regras.

O influenciador Kahlil Greene, que partilha vídeos sobre a história da comunidade negra, começou a publicar mais no Instagram depois de perceber que o TikTok não sugeria as suas publicações a outros utilizadores ou chegava mesmo a removê-las. O criador de conteúdo teve, por exemplo, de alterar uma citação da “Carta de uma prisão em Birmingham” (“Letter from Birmingham Jail”, em inglês), escrita por Martin Luther King em 1963. No vídeo, “Ku Klux Klanner” teve que passar a “Ku K1ux K1ann3r” ou “white moderate” a “wh1t3 moderate”.

@kahlilgreene Comment your favorite MLK quotes #mlk #mlkday #mlkday2021 #blm #politics inspired by @bobacommie ♬ Glory (From the Motion Picture Selma) - Common & John Legend

Os relatos da existência de uma “área cinzenta” quanto à moderação relativa à linguagem não ficam por aqui. A comunidade LGBTQIA+ considera-se como uma das mais afetadas pela “censura”. Griffin Maxwell Brooks, influencer, reparou que os seus vídeos que falavam sobre a comunidade homossexual eram sinalizados: “É frustrante porque a censura parece variar” consoante os temas, denunciou.

Afinal, que conteúdos não aparecem na página “For You”?

Os influenciadores acreditam na existência de palavras proibidas, mas o “livro” de regras do TikTok não faz qualquer menção a isso. Explica, sim, que tipo de conteúdos não são elegíveis para aparecer na página “For You” — que recomenda conteúdos aos utilizadores com base em publicações com que interagem. Nas diretrizes, a rede social admite que pode “tornar vídeos inelegíveis para recomendação no feed ‘For You'”. Que posts são estes que, para “assegurar a segurança dos utilizadores”, não merecem destaque da plataforma?

Os vídeos que retratem “nudez implícita”, que são “descaradamente eróticos ou sensuais (por exemplo, strip teases)” ou que promovam tabaco e álcool “de forma perigosa” podem não ser elegíveis para recomendação. Teorias da conspiração, conteúdos de utilizadores com menos de 16 anos e publicações que podem “causar desconforto, choque ou repulsa”, como vídeos de “maquilhagem que replicam, de forma realística, feridas”, também não chegam à página “For You”. Além disso, os vídeos com menções a cirurgias plásticas “sem alertar para os riscos”, publicações de não profissionais a praticar “acrobacias” ou “desportos extremos” que podem ser perigosos “quando replicados sem precauções de segurança” e conteúdos importados de outras plataformas são inelegíveis.

Os especialistas acreditam que o algospeak não veio para ficar e que não vai alterar o discurso do quotidiano. Nicole Holliday, professora assistente de linguística na faculdade Pomona College, na Califórnia, afirma que quando os mais velhos começam a utilizar os códigos que os jovens criaram, esses tornam-se “obsoletos”. Em declarações ao The New York Times, diz ainda que os mais novos adequam o discurso às circunstâncias em que se encontram — não utilizando, por exemplo, o vocabulário que utilizam nas redes sociais nas aulas.

Por sua vez, Evan Greer considera que combater o uso de palavras específicas “não funciona” e é em vão. Ao The Washington Post, o diretor do Fight for the Future, organização sem fins lucrativos de defesa dos direitos digitais, defende que não é ao não dar destaque a determinadas palavras que as redes sociais vão conseguir moderar a linguagem.